RTX 4090 Gaming X Trio - Recensione

12 ottobre 2022

Nvidia ritorna nei giochi con la sua nuova ammiraglia, la RTX 4090. Abbiamo avuto modo di provarla nella versione custom Gaming X Trio di MSI.

Ad ormai due anni dall’uscita delle prime schede video Ampere, dopo mesi e mesi di speculazione, abbiamo tra le mani le prime schede della serie RTX 40, basate sull’architettura Ada Lovelace. Per questo lancio NVIDIA ha deciso di partire dalla top di gamma, a meno di future versioni Ti, ovvero la RTX 4090. Si tratta di un lieve cambio di programma, visto che nelle precedenti generazioni le prime schede ad essere lanciate erano solitamente quelle della classe xx80; questo riporta un po’ indietro al periodo in cui le schede xx80 erano effettivamente le top di gamma, oltre 10 anni fa. Nella recensione di oggi, in particolare, analizzeremo il modello Gaming X Trio gentilmente fornito da MSI. Ma prima diamo un’occhiata alle novità presenti su questa nuova serie di schede NVIDIA.

🔗 RTX 4090 Gaming X Trio - Clicca qui per acquistare

L’architettura Ada Lovelace #

Sin dalla fondazione dell’azienda, le architetture NVIDIA portano sempre il nome di grandi scienziati del passato. In questo caso la scelta è ricaduta su Ada Lovelace, nome con cui è meglio conosciuta Augusta Ada Byron, contessa di Lovelace, figlia del poeta Lord Byron e della matematica Anne Isabella Milbanke. Ada Lovelace è annoverata tra i più influenti pionieri della storia dei computer: è suo il primo algoritmo per computer ad essere mai stato pubblicato, inteso per essere eseguito dalla macchina analitica ideata da Charles Babbage. Dopo Marie Curie (GeForce 6 e 7) ed insieme alla matematica ed informatica Grace Hopper (serie Hopper per datacenter e HPC), è la seconda donna a cui è dedicata un’architettura della casa verde.

Ada Lovelace nel 1836

Specifiche dei chip Ada Lovelace - AD102 #

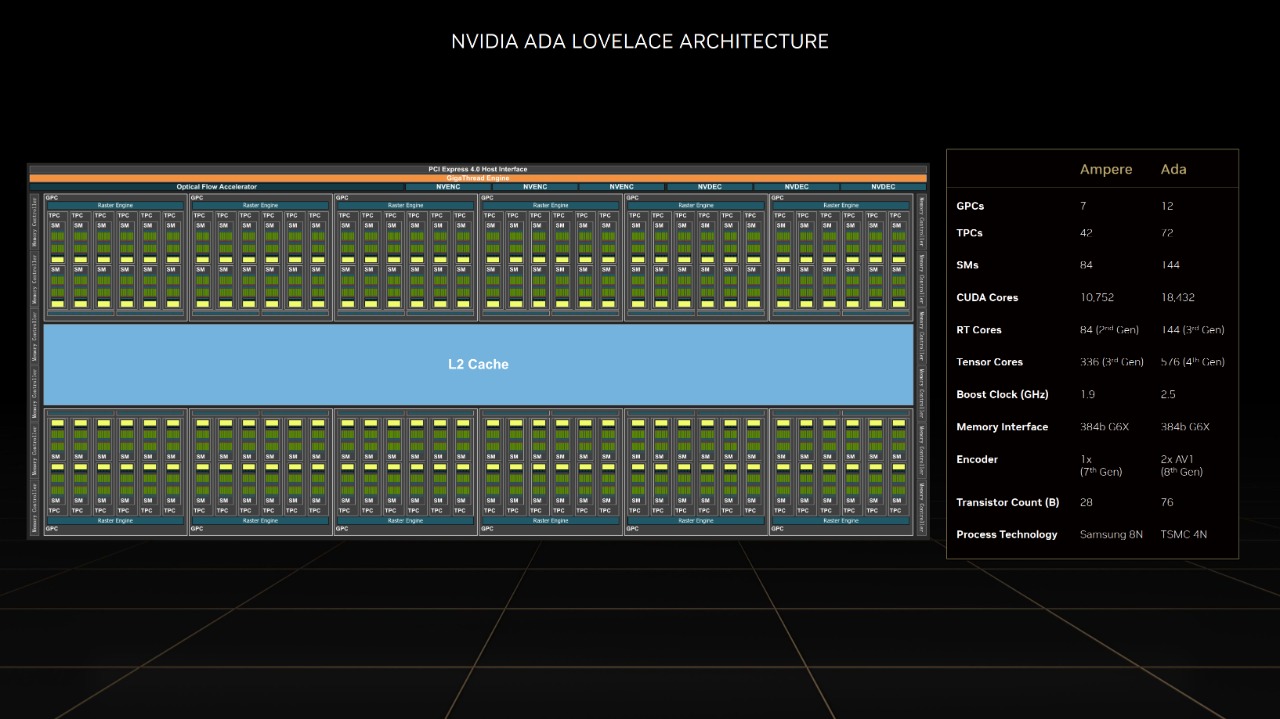

Dal punto di vista tecnico, l’architettura Ada Lovelace presenta alcune similarità con Ampere ma anche molte differenze.

La prima è il passaggio ad un nodo molto più avanzato, N4 di TSMC: i chip Ampere erano su 8nm Samsung, che nonostante il nome è un processo produttivo di “classe” 10nm, mentre N4 di TSMC rappresenta una versione leggermente migliorata di N5, ovvero un processo di “classe” 5nm. Ciò permette al chip AD102 di ospitare, nonostante l’area leggermente inferiore, quasi il triplo dei transistor del precedente GA102, usato per RTX 3080 e 3090. Inoltre, dopo una “stagnazione” delle frequenze rimaste all’incirca stabili dai tempi di Pascal al di sotto dei 2000 MHz, grazie al nuovo nodo le RTX 40 hanno frequenze di boost di oltre 2500 MHz, attestandosi sui 2700-2800 MHz in gioco.

Il chip AD102 completo

La struttura degli SM (Streaming Multiprocessor) è rimasta simile ad Ampere: un RT Core, quattro tensor core e 128 CUDA core, di cui 64 unità esclusivamente FP32 e le altre 64 capaci di eseguire alternativamente operazioni FP32 o INT32; sono inoltre presenti, ma non mostrate nei diagrammi, due unità FP64 per SM. Sul chip AD102 completo sono presenti 144 SM raggruppati in 12 GPC (Graphics Processing Clusters) per un totale di 18432 CUDA Core, 144 RT Core, 576 tensor core e 576 texture unit. Sulla RTX 4090 i GPC attivi sono 11: ciò si traduce in 128 SM, quindi 16384 CUDA core, 128 RT core, 512 tensor core e 512 texture unit.

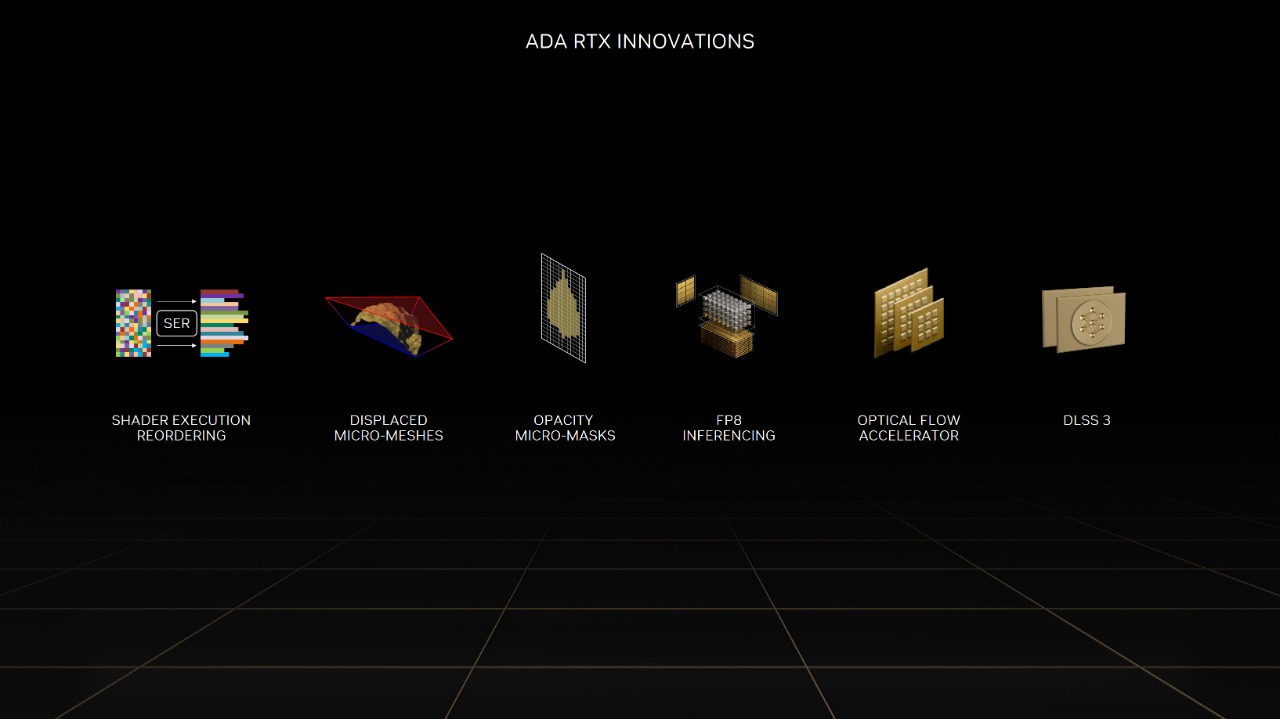

Tensor e RT core #

Tensor core e RT core, tuttavia, sono aggiornati rispettivamente alla quarta e terza generazione, che porta grossi vantaggi nel calcolo tensoriale e nelle performance in raytracing.

I tensor core Ada forniscono oltre il doppio del throughput FP16, BF16, TF32, INT8, e INT4, ciò si riflette ovviamente sul calcolo tensoriale ed applicazioni AI ed HPC. Le migliorie dal lato degli RT core sono ancora maggiori:

- throughput doppio per intersezioni raggio-triangolo;

- alpha traversal due volte più veloce: il nuovo Opacity Micromap Engine può testare direttamente la geometria alfa e ridurre i calcoli alfa basati sugli shader, utile per descrivere in modo compatto oggetti di forma irregolare o traslucidi e tracciarli direttamente e in modo più efficiente;

- build delle BHV 10 volte più veloce in 1/20 dello spazio.

Alcune delle feature di Lovelace

Gli RT core di terza generazione supportano inoltre il SER (Shader Execution Reordering), che permette di riorganizzare le operazioni di shading divergenti, le quali tendono ad essere molto comuni in caso di path tracing, riflessi multipli e materiali dalle superfici complesse. Con questo meccanismo, simile allo scheduling out-of-order presente sui core CPU ad alte prestazioni, si può ridurre di molto l’overhead e quindi aumentare il throughput. In generale, l’impatto prestazionale del raytracing sulle GPU Lovelace è molto inferiore rispetto alle generazioni precedenti.

Questi miglioramenti su tensor ed RT core sottolineano come NVIDIA stia puntando molto su raytracing e DLSS, anziché esclusivamente sulla forza bruta.

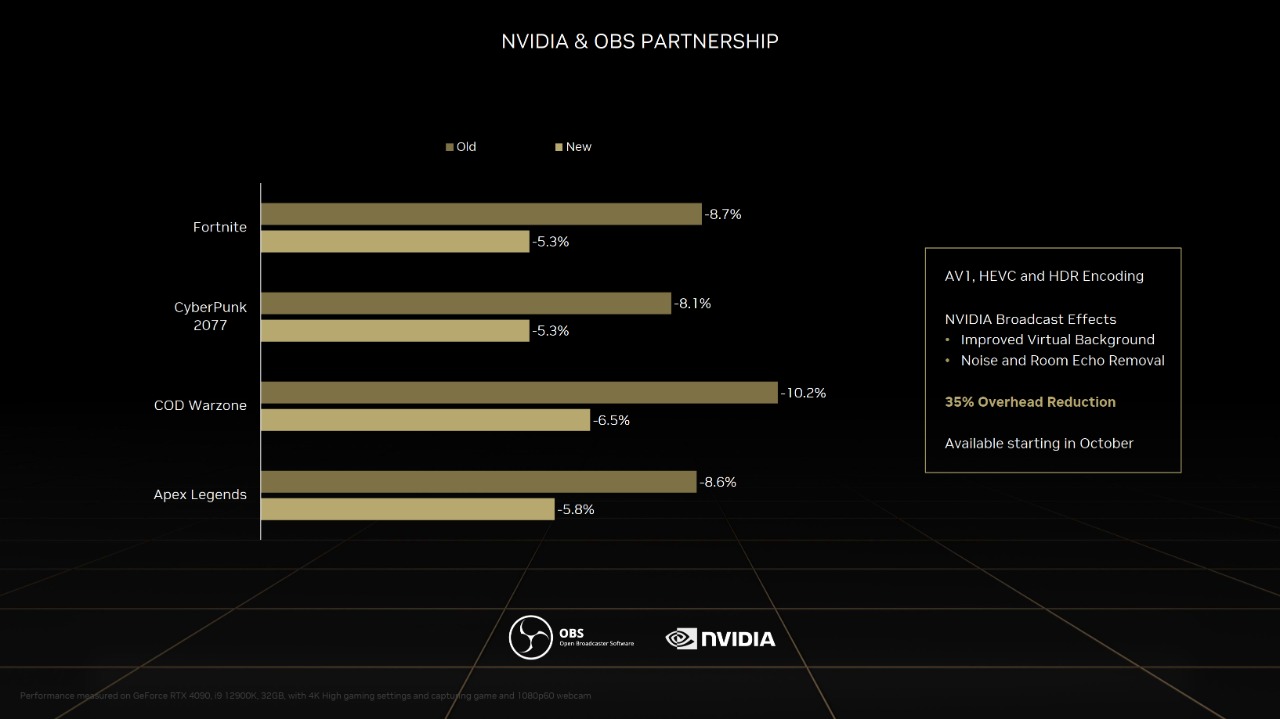

Encoder e sottosistema di memoria #

Sulle GPU Ada, in particolare quelle dotate di più di 12 GB di VRAM (4080 12GB e superiori), si trovano inoltre due nuovi encoder NVENC ed un decoder NDEC entrambi compatibili con il codec AV1, che è ormai destinato a rimpiazzare il più diffuso H264 nello streaming di contenuti video. Sul chip AD102, in realtà, sono presenti tre decoder e tre encoder, ma sono totalmente attivi solo sulle schede professionali (le ex Quadro, per intenderci).

Il nuovo encoder permette minore overhead e migliore qualità visiva, oltre a nuove funzionalità per NVIDIA Broadcast

Infine, AD102 è dotato di una cache L2 molto maggiore rispetto ai chip di architetture precedenti. Sono presenti ben 72 MB di L2, contro i 6 MB del GA102, probabilmente utili per mantenere ben alimentate le unità di calcolo: il sottosistema di memoria è rimasto infatti uguale alla RTX 3090 Ti, con un bus a 384 bit con GDDR6X a 21 Gbps, per un totale di 1008 GB/s di banda teorica. Una mossa molto simile a quella attuata da AMD con l’Infinity Cache sulle RX 6000, che è tuttavia più grande ed in configurazione L3.

Novità software #

In contemporanea all’annuncio delle nuove schede, NVIDIA ha presentato anche due interessanti novità software, RTX Remix e soprattutto la terza iterazione del DLSS.

DLSS 3 #

Nella sua prima versione, il DLSS supportava solo l’upscaling di tipo spaziale, necessitava di training presso i datacenter NVIDIA e restituiva un risultato non particolarmente gradevole, con immagini sfocate ed alcuni artefatti grafici. Ciò era anche dovuto ad un utilizzo praticamente nullo dei tensor core per lo scopo.

Il passaggio alla seconda versione è stato un grosso salto in avanti, con l’aggiunta della componente temporale dei motion vector nell’upscaling, di un vero uso dei tensor core e della rimozione della necessità di pre-training. In questo modo il DLSS2 è diventata la prima vera versione della tecnologia davvero utilizzabile, con alta qualità dell’immagine e ottima ricostruzione delle scene a partire da risoluzioni inferiori. Seppure la componente temporale tenda ad introdurre un leggero effetto ghosting, ciò è altamente compensato dal risultato ed è solitamente migliorabile dagli sviluppatori dei giochi.

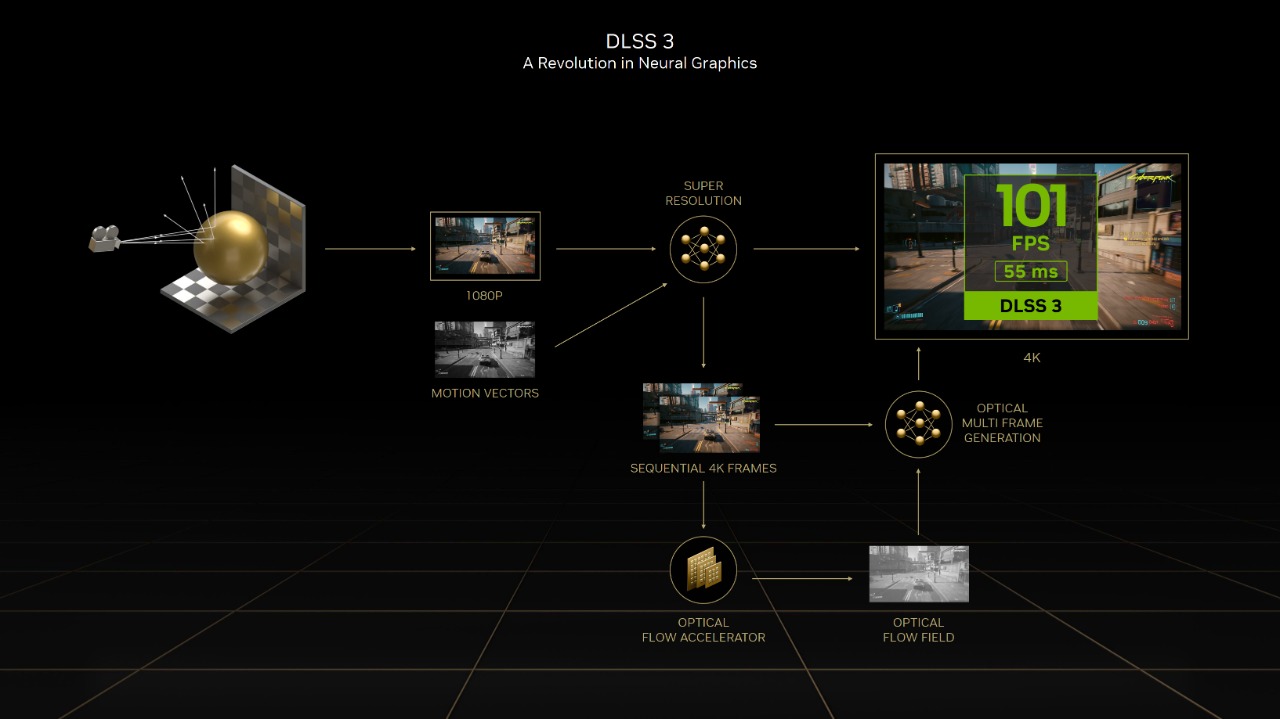

Schema semplificato del funzionamento del DLSS 3. Il processo di upscaling è il medesimo del DLSS 2

Il DLSS 3 prende invece un’altra strada: mantiene lo stesso procedimento di upscaling della versione precedente, ma aggiunge un passaggio critico, ovvero l’inserimento di un fotogramma totalmente nuovo dato dall’interpolazione del precedente e del successivo. In questo modo dalle stesse informazioni si ricavano 3 frame anziché 2, consentendo un guadagno teorico di FPS del 50% rispetto al DLSS2 a parità di impostazioni. Essendo un processo che avviene interamente nel framebuffer della scheda video, non è necessario che CPU e GPU comunichino tra loro per la generazione di questo fotogramma aggiuntivo, “bypassando” un eventuale collo di bottiglia del processore e facendo sì che questo non influisca negativamente sul framerate.

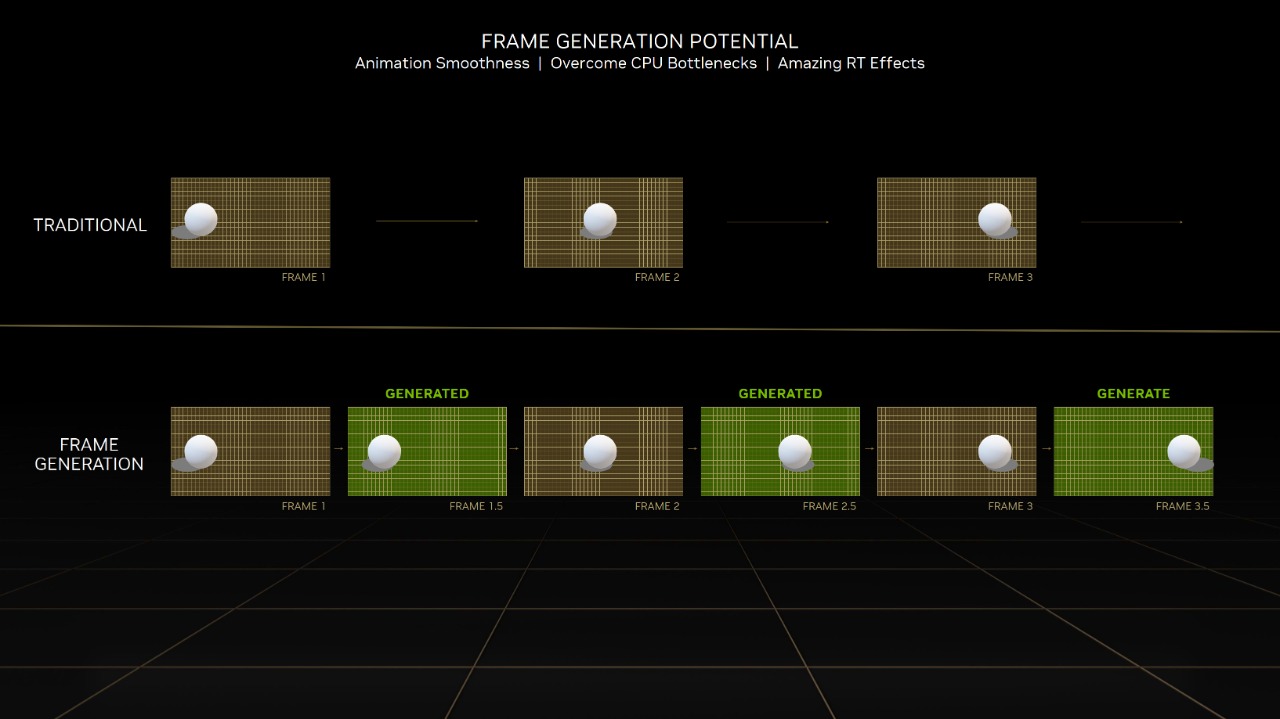

Esempio di rendering con generazione di frame

Questo è possibile solo su GPU Ada Lovelace, essendo presente un nuovo Optical Flow Accelerator dedicato allo scopo: una unità simile era presente già dall’architettura Turing, ma non è capace di svolgere questo lavoro mantenendo latenze contenute. In termini delle suddette latenze, è comunque impossibile abbassarle interpolando un frame aggiuntivo tra due già disponibili, quindi si ottiene un aumento di framerate non direttamente correlato ad una diminuzione di frametime, quindi latenza, come accade di norma. Ciò va verificato, quindi, non solo da un punto di vista numerico, ma anche qualitativo e personale, per capire se l’aumento di framerate si rifletta effettivamente sull’esperienza di gioco.

RTX Remix #

Altra interessante aggiunta alla suite di software NVIDIA è RTX Remix: si tratta di una nuova piattaforma basata su NVIDIA Omniverse che consente di creare mod grafiche per giochi datati in maniera intuitiva.

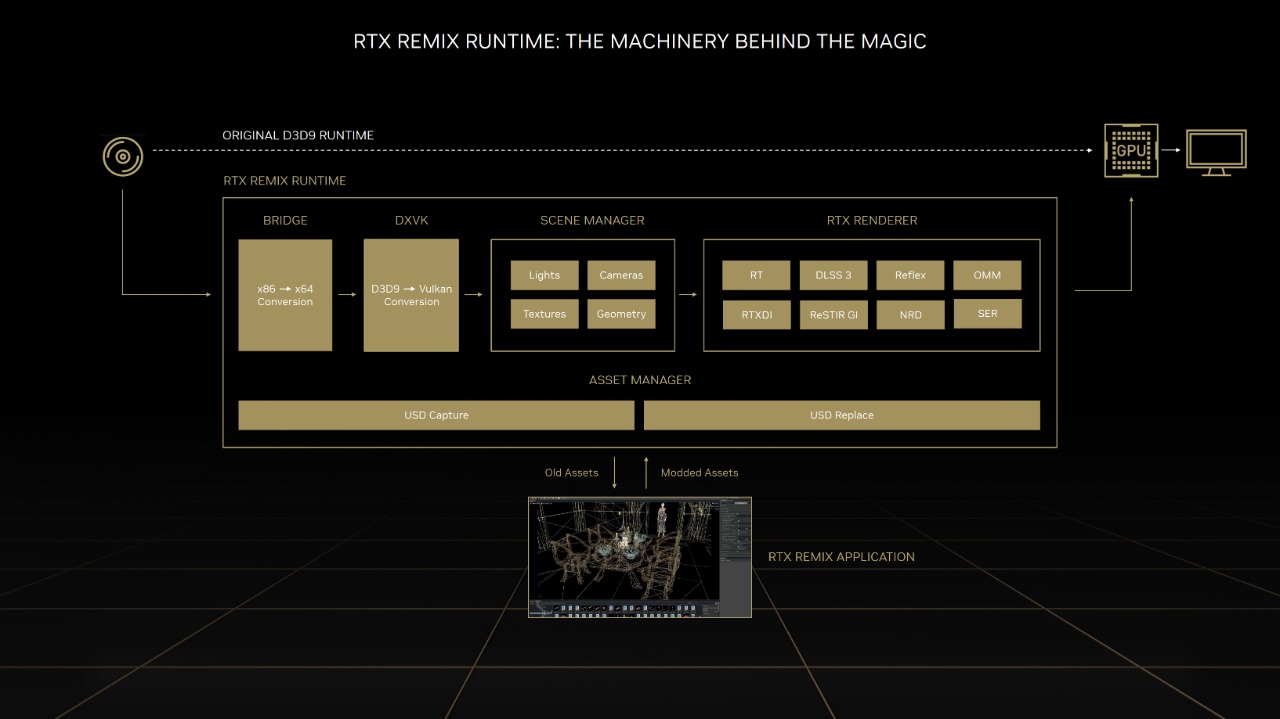

Le potenzialità di RTX Remix

Partendo dalla cattura direttamente in game e da una conversione automatica in USD (Universal Scene Description), è possibile creare mod visive rapidamente e con la possibilità di integrare DLSS, RayTracing e texture migliorate tramite tool AI. Saranno supportati giochi DX8 e DX9, ai quali sarà possibile aggiungere le migliorie citate tramite una prima conversione (automatica) in Vulkan tramite DXVK.

È un’idea molto promettente per chi ama giocare a vecchi giochi e soprattutto per la community di modder ancora attiva su di essi; ci sono molti giochi “storici” che vale la pena recuperare, ma che visivamente non hanno ben retto la prova del tempo.

La routine di RTX Remix

Caratteristiche generali RTX 4090 #

La RTX 4090 si presenta sul mercato con un miglioramento generale di quasi ogni comparto. Il processo produttivo passa dagli 8 nm di Samsung (10 nm class) ai 5 di TSMC con il nodo N4. Questo miglioramento porta anche a quasi triplicare i transistor, che passano da 28.3 miliardi a 76.3 miliardi. Il chip invece si riduce leggermente dai 682 mm^2 della 3090 (GA102) ai 608 mm^2 di AD102.

Si chiude il cerchio con il TDP, che ammonta a 450 W come quello della 3090 Ti, ma totalizzando una frequenza di 2520 a stock contro i 1850 MHz della RTX 3090 Ti. Rimangono invece invariati i 24 GB di memorie GDDR6X a 21.2 Gbps, un miglioramente marginale rispetto ai 21 Gbps della 3090 Ti.

Gaming X Trio: una custom imponente #

In questo caso abbiamo avuto modo di recensire la RTX 4090 Gaming X Trio di MSI. Questa scheda non è la top di gamma della casa del dragone, il primo posto sul podio spetta alle 2 Suprim, ma è comunque tra le più performanti.

Si tratta di una scheda video con 3 ventole assiali, quasi identica esteticamente al modello dedicato alla dissipazione di Ampere. Le differenze principali sono nella forma del “taglio” che fa spazio alla luce degli RGB. Per il resto incrementano le dimensioni del dissipatore e leggermente la lunghezza (323 mm per la 3090 Gaming X Trio contro i 337 della 4090).

Temperature, consumi e rumore #

Per quanto riguarda le prestazioni della scheda, è davvero ottima. Rispetto alle custom RTX 3090 e RTX 3090 Ti, la situazione è migliorata nettamente. In questo caso non ci distacchiamo di tanto in termini di consumi dalle precedenti top di gamma. Nonostante il TDP dichiarato di 450W, solitamente un valore molto vicino al Total Board Power, la scheda lavora in un range operativa tra i 390 e 420 W quando utilizzata al massimo delle sue possibilità, con solo qualche occasionale picco verso i 435 - 440 W.

In alcuni contesti di gioco, specie con titoli più vecchi, abbiamo riscontrato consumi oscillanti tra i 300 e i 400 W, come per esempio nel caso di Shadow Of The Tomb Raider.

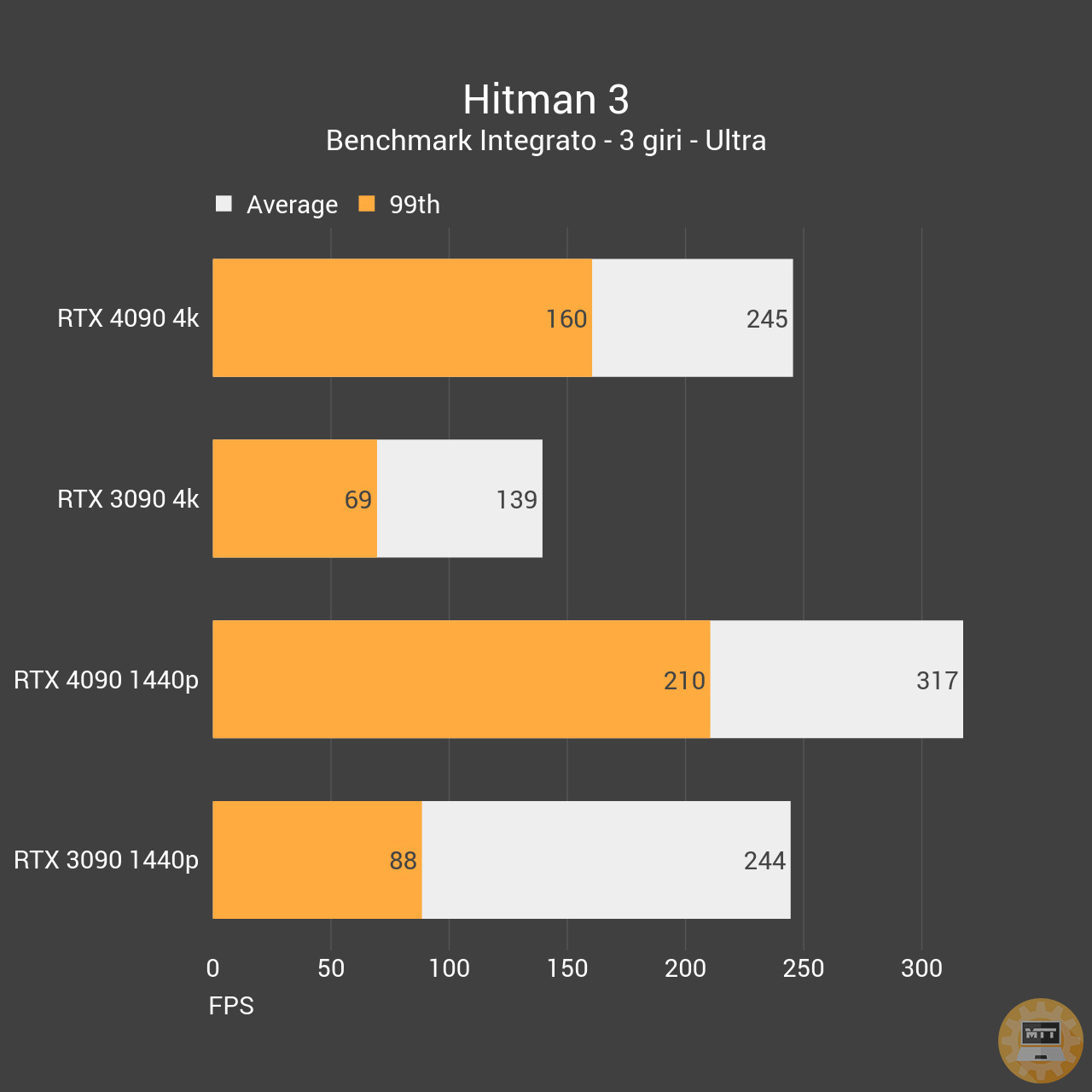

Per quanto riguarda le temperature anche qui tutto dipende dal gioco e dal carico in atto. Nelle fasi di gioco anche più intense, complice una temperatura ambientale di 23°C la RTX 4090 si è dimostrata capace di mantenere una temperatura oscillante tra i 64°C di Hitman 3 in 4k fino ai 70°C del più feroce Cyberpunk, sempre in 4k ma con Ray Tracing attivo per godere al meglio dell’esperienza. Il limite massimo lo abbiamo raggiunto con 3D Mark Time Spy Extreme, che nel test più impegnativo ha spinto la scheda a 73-74°C. Ma è un caso limite che non si è verificato in contesti “reali”.

Per quanto riguarda le ventole, questa custom si difende benissimo con un range operativo massimo una volta toccati i 400W del 45%, rimanendo quindi molto silenziosa. A paragone con una RTX 3090 ROG STRIX WHITE OC, la scheda è nettamente più apprezzabile su questo punto di vista, visto che la custom di casa Asus, con consumi tra i 390 e 400 W in picco, richiede un buon 85% delle rotazioni massime per mantenere la temperatura di 70°C in contesti di gioco.

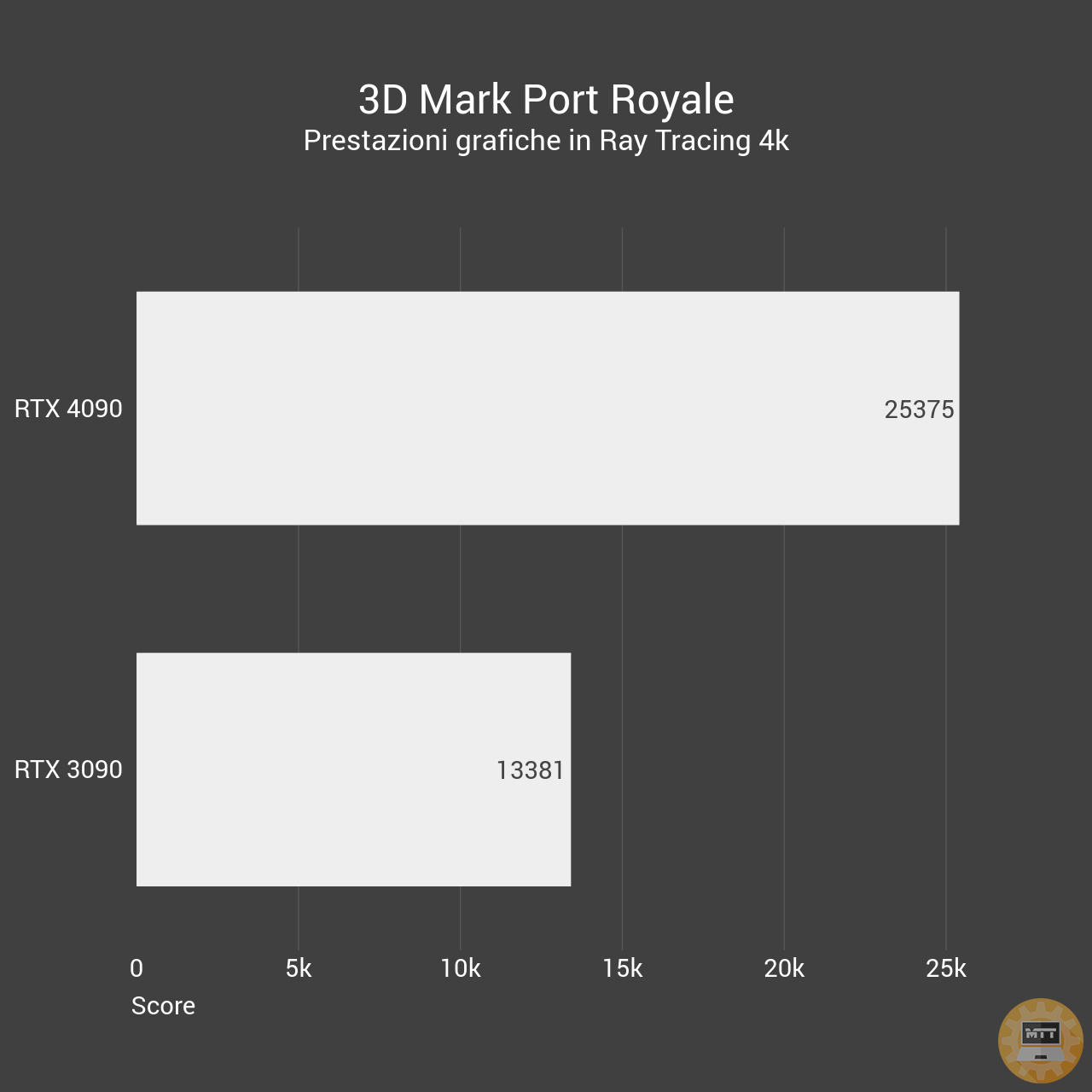

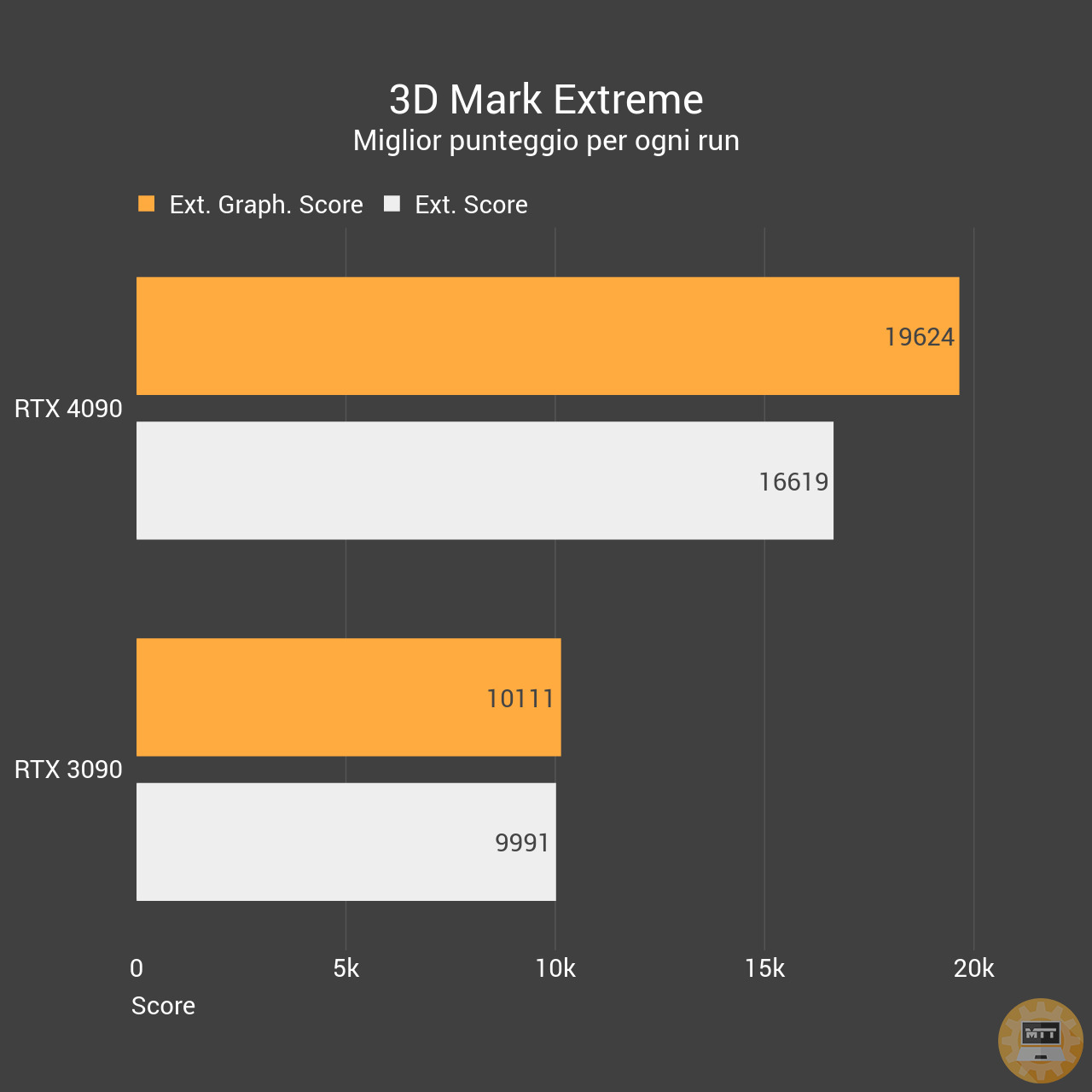

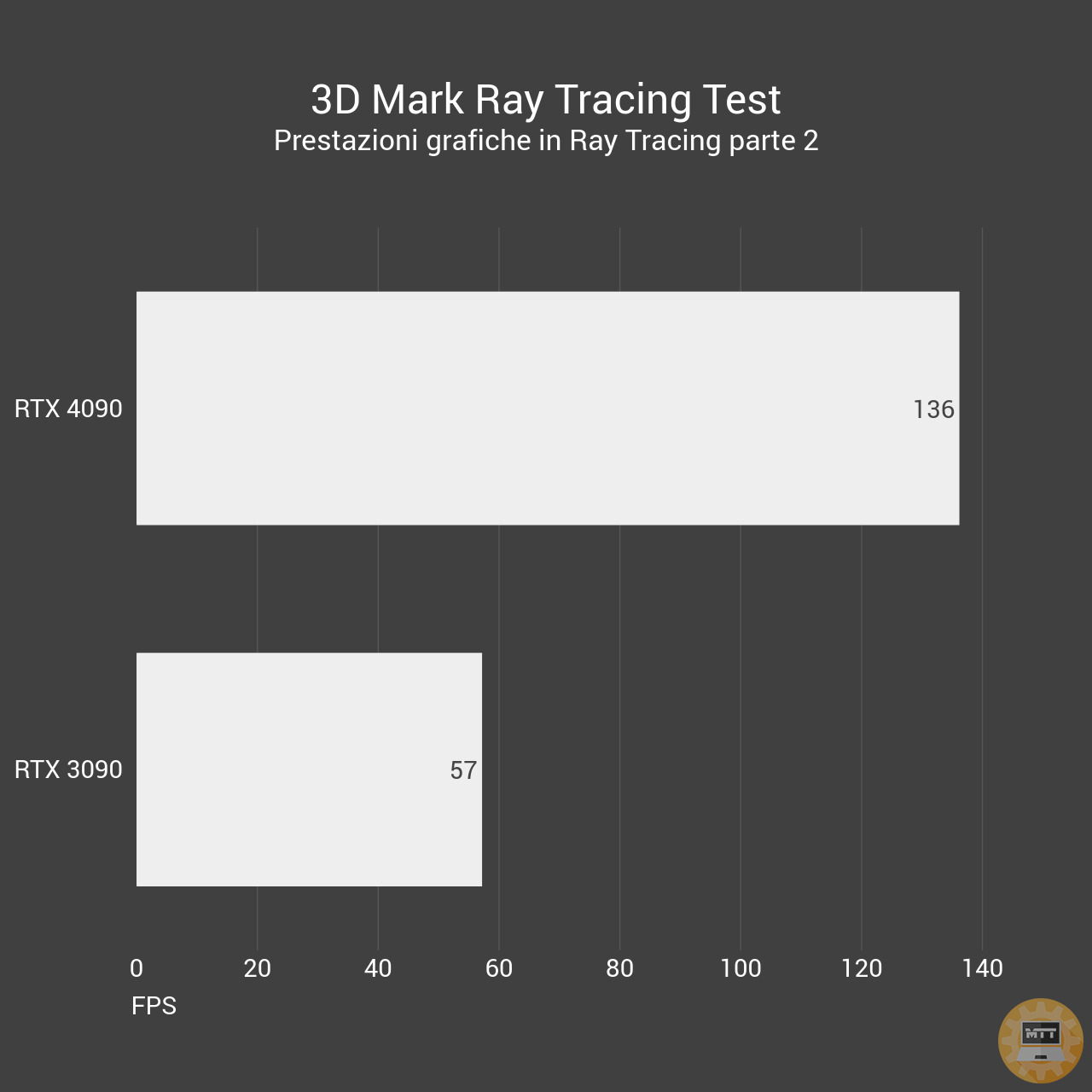

Prestazioni - 3D Mark #

I primi test che eseguiamo sempre nel nostro roster sono quelli di 3D Mark, una suite incredibilmente precisa e completa per valutare in maniera generale quale sarà il posizionamento delle nuove schede rispetto alle generazioni precedenti. E i risultati sono quantomeno fenomenali. Siamo di fronte una 4090 che tritura la RTX 3090 senza alcun problema i ntutti gli ambiti, dal raster nudo e crudo alle prestazioni in Ray Tracing.

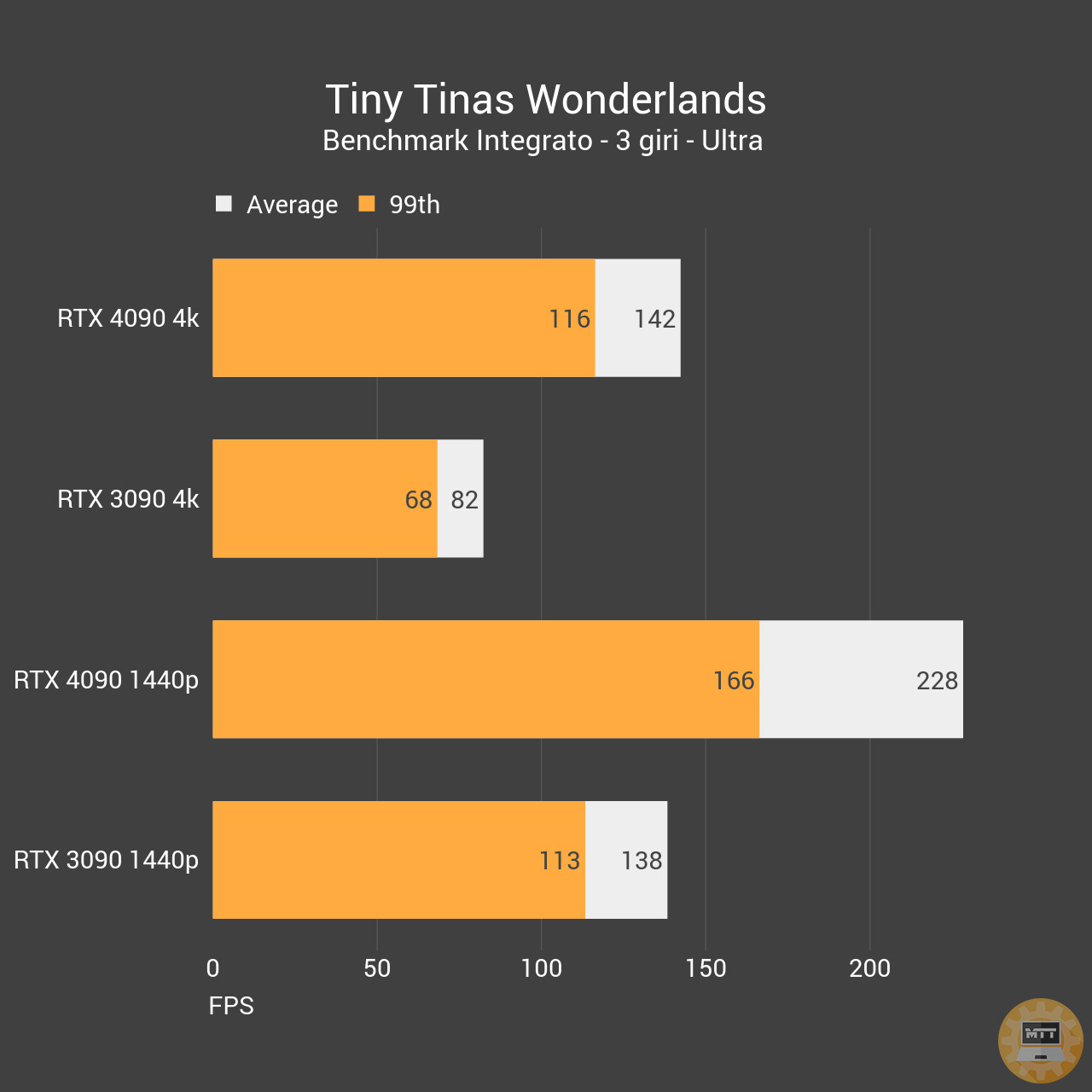

Prestazioni - Gaming #

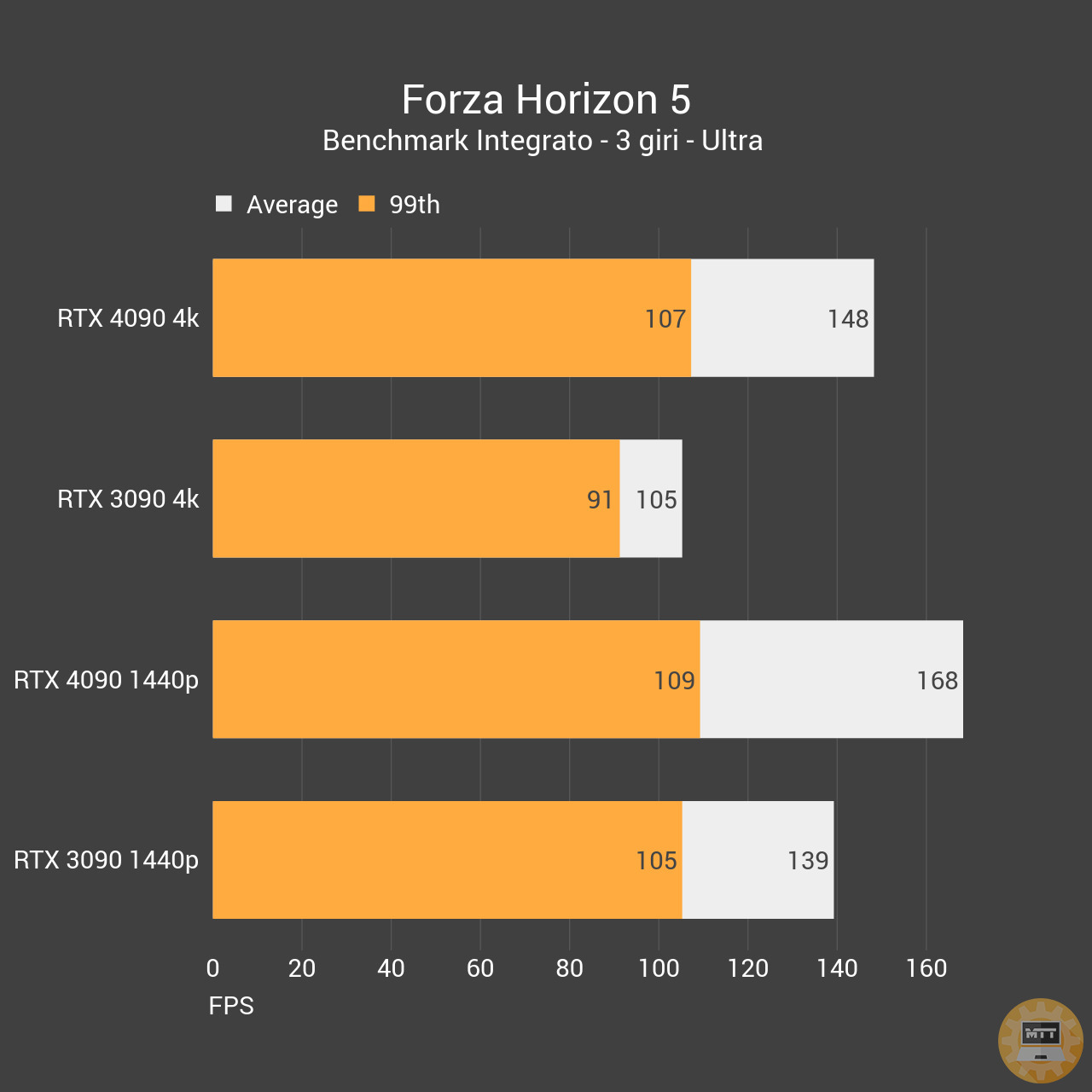

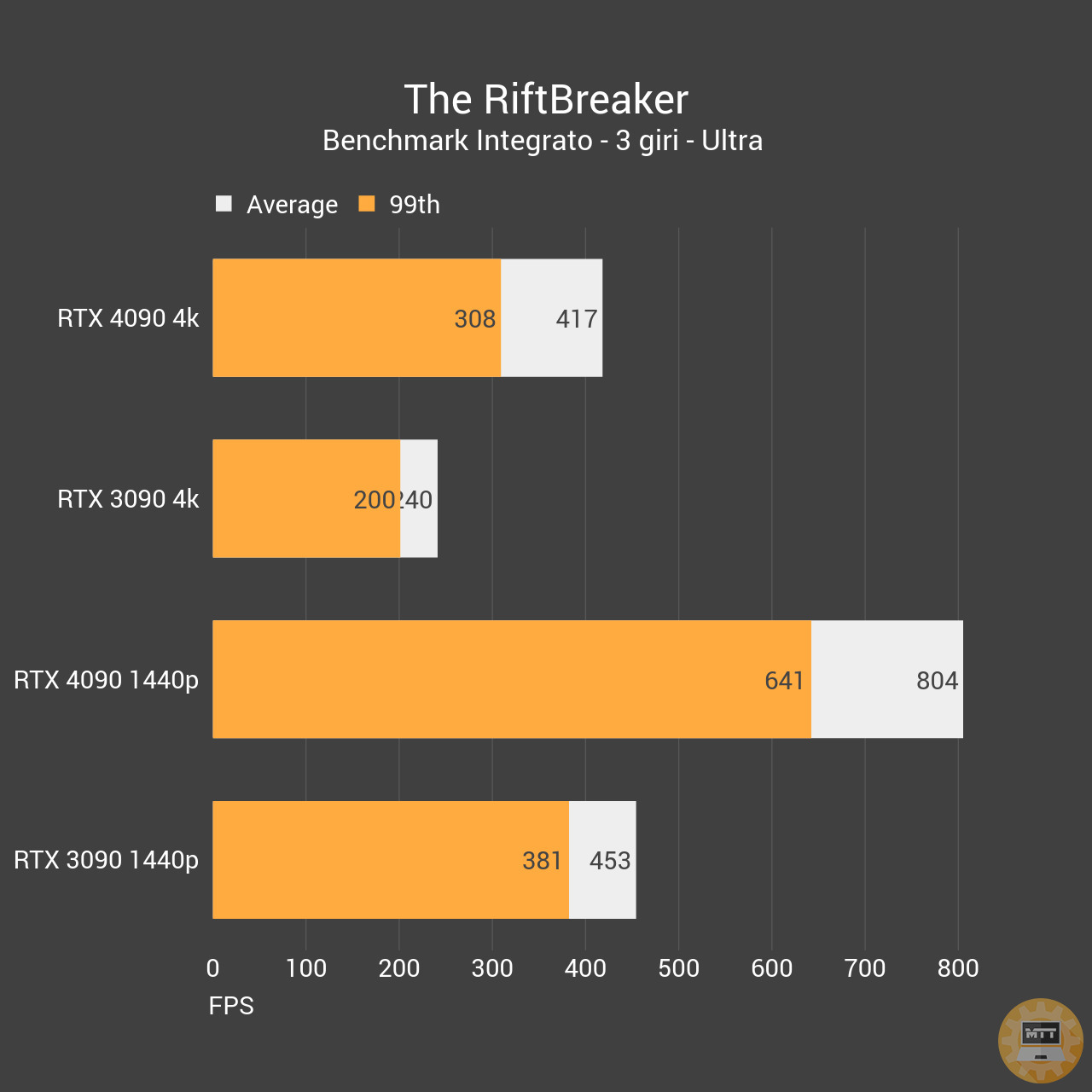

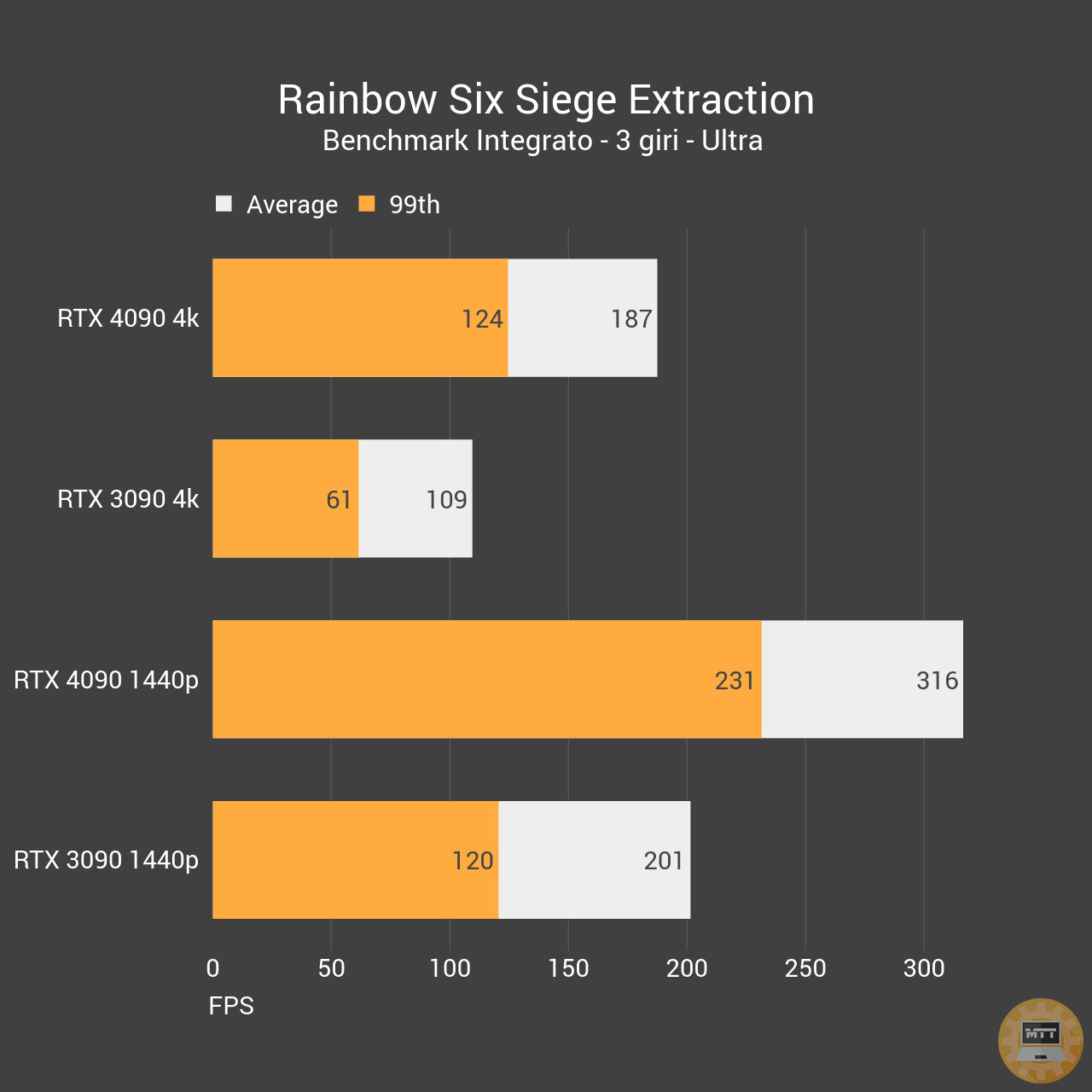

Per quanto riguarda il gaming invece la scheda perde qualche punto percentuale sul distacco appena visto, ma di sicuro non la si può criticare. Con un consumo praticamente pari a quello della ROG STRIX in nostro possesso, le performance sono tra il 60% e il 100% meglio in 1440p e in 4k, parlando di un’esperienza che ancora deve abbracciare Ray Tracing e DLSS.

La 4090 è la prima scheda a fornire delle prestazioni così impressionanti in 4k, superando il muro dei 100 FPS in molti giochi e andando a toccare i 200 in altri. Con l’aggiunta del DLSS 2 e DLSS 3 questa scheda può offrire esperienze visive senza precedenti.

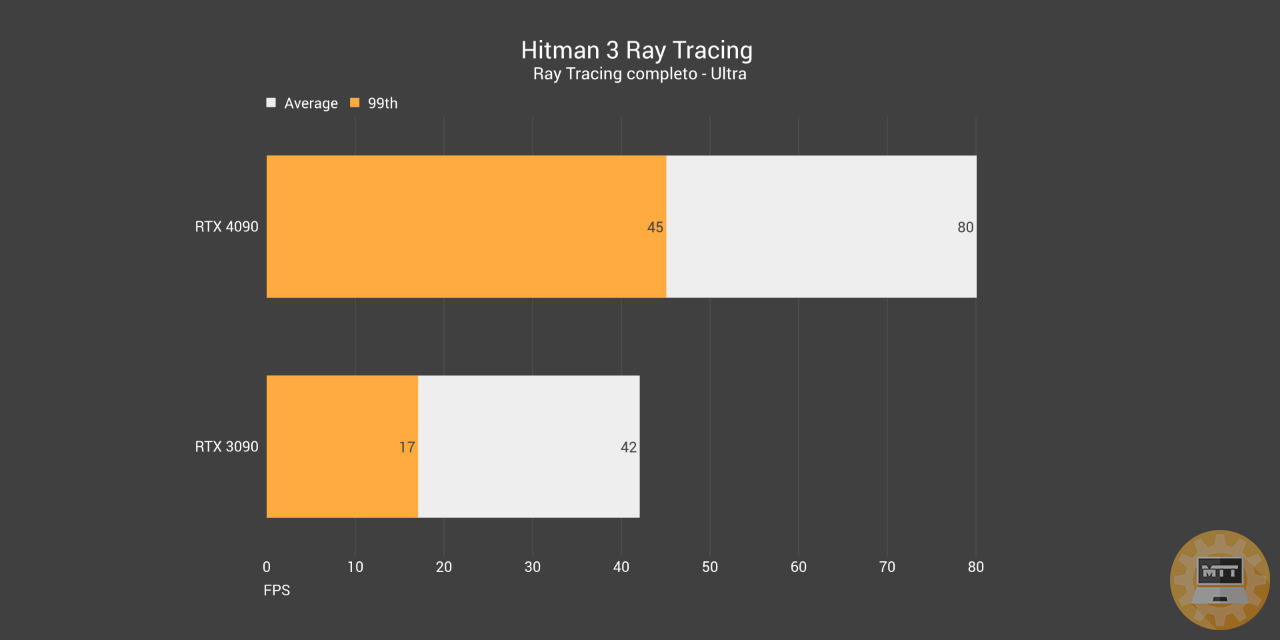

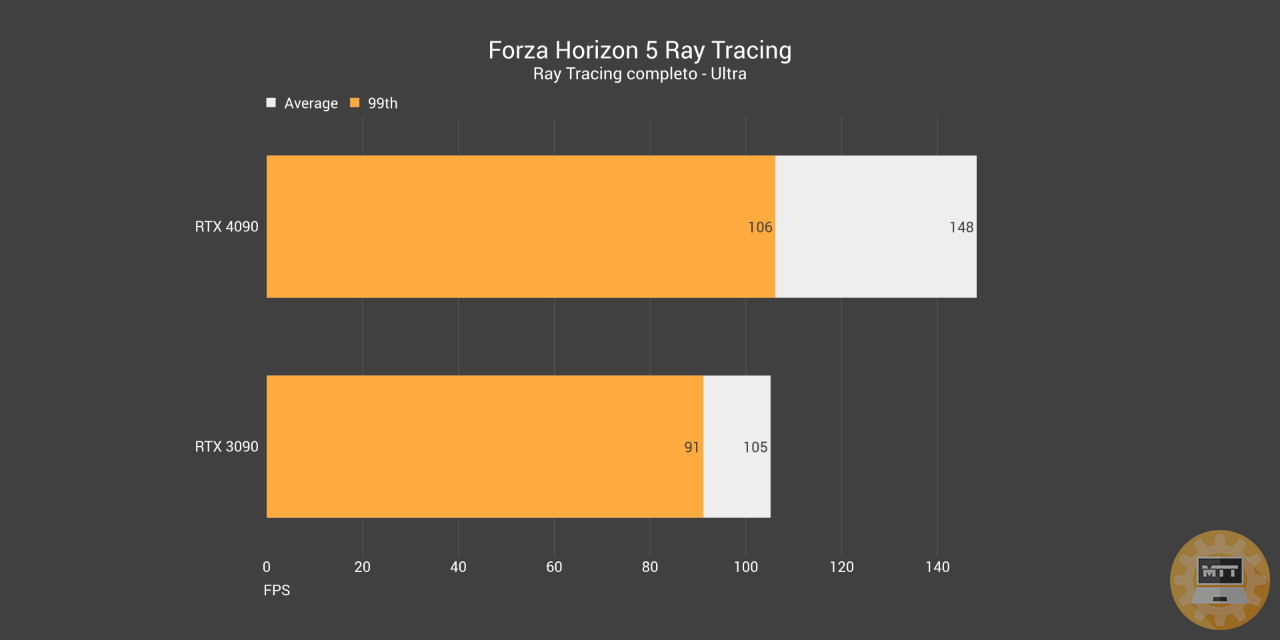

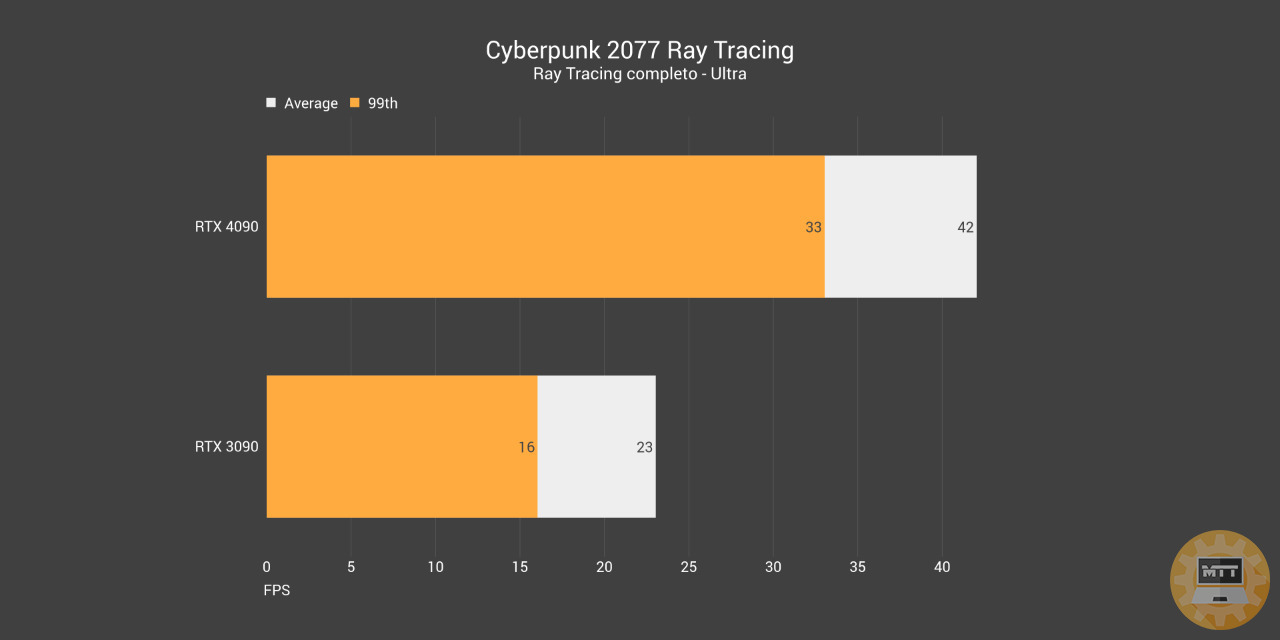

Ray Tracing #

Inutile a dirsi, anche in Ray Tracing la RTX 4090 si comporta benissimo, con un distacco netto e significativo rispetto alla RTX 3090. Questo è un segnale importante, in quanto la scheda in più giochi ha la possibilità di offrire un’esperienza completa in 4k ancora prima di attivare il DLSS 2 o 3 che si voglia. Sicuramente un ottimo punto.

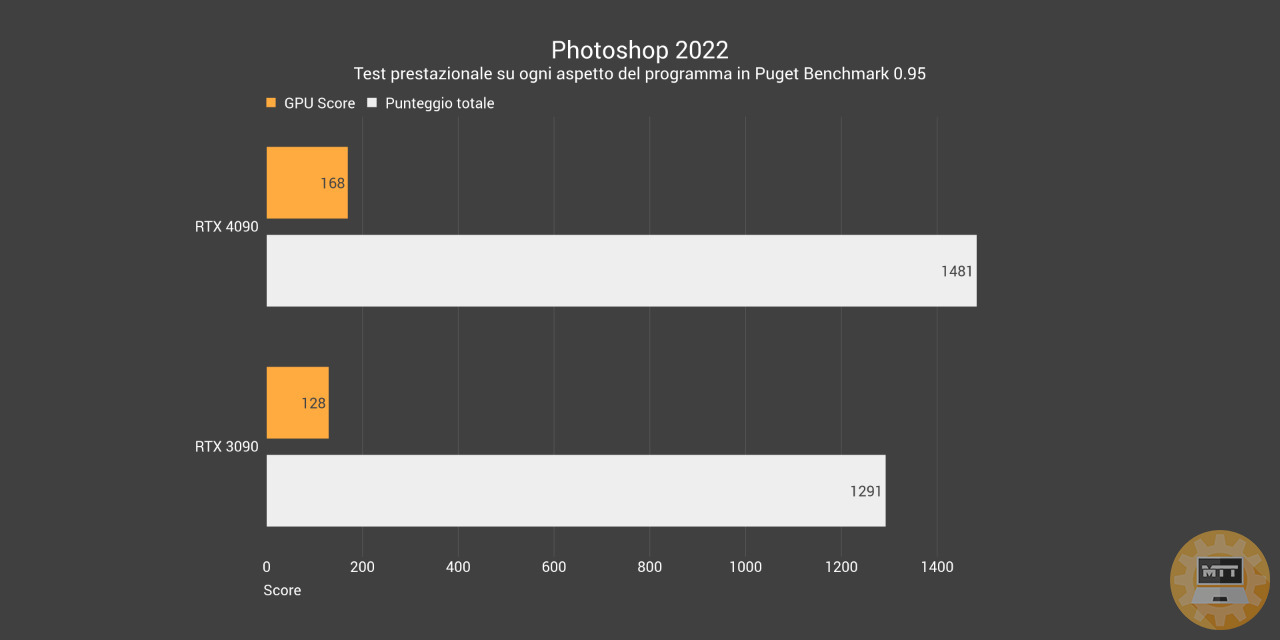

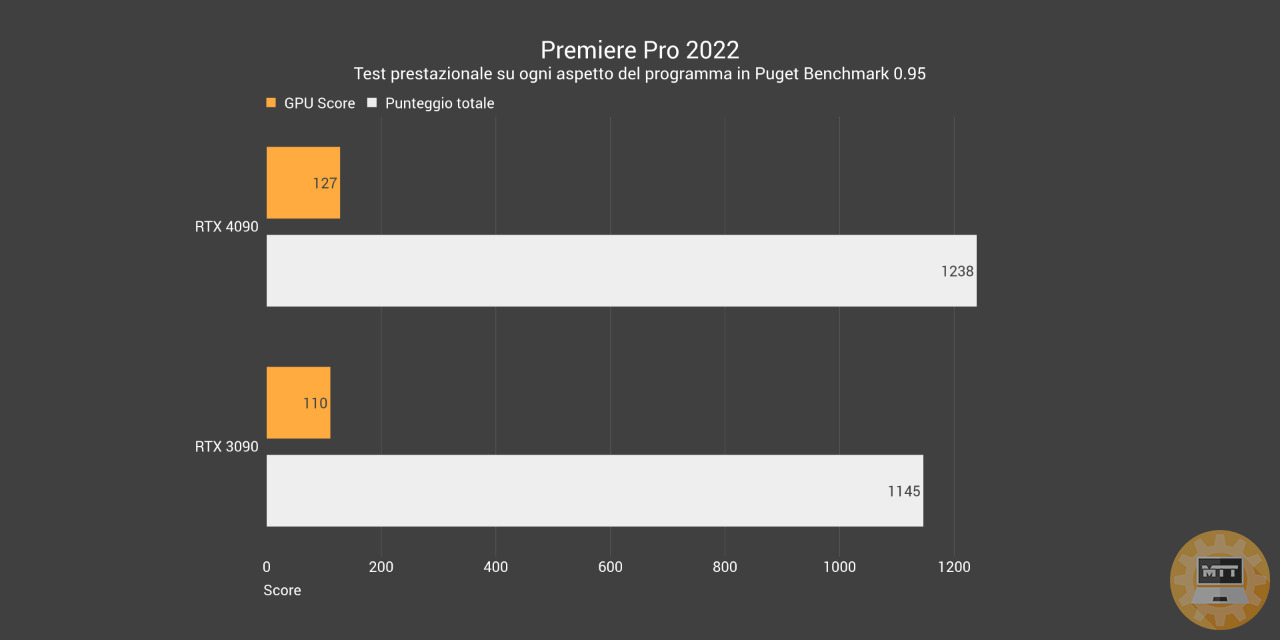

Prestazioni - Produttività #

Ma ovviamente si può analizzare una scheda da oltre 2000 euro e con la bellezza di 24 GB di vram GDDR6X solo dal punto di vista del gaming? chiaro che no!

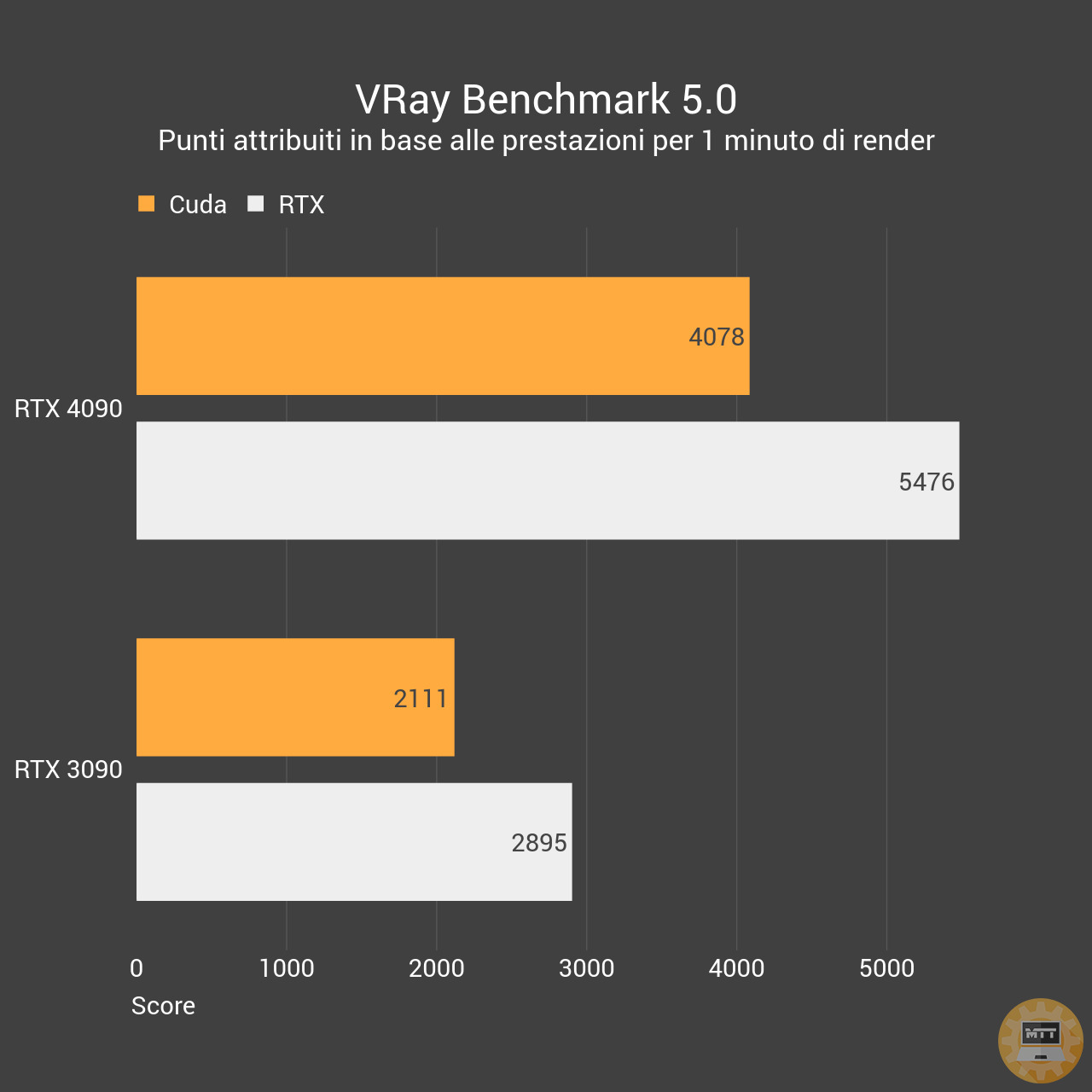

Vray Benchmark RTX 4090 vs RTX 3090

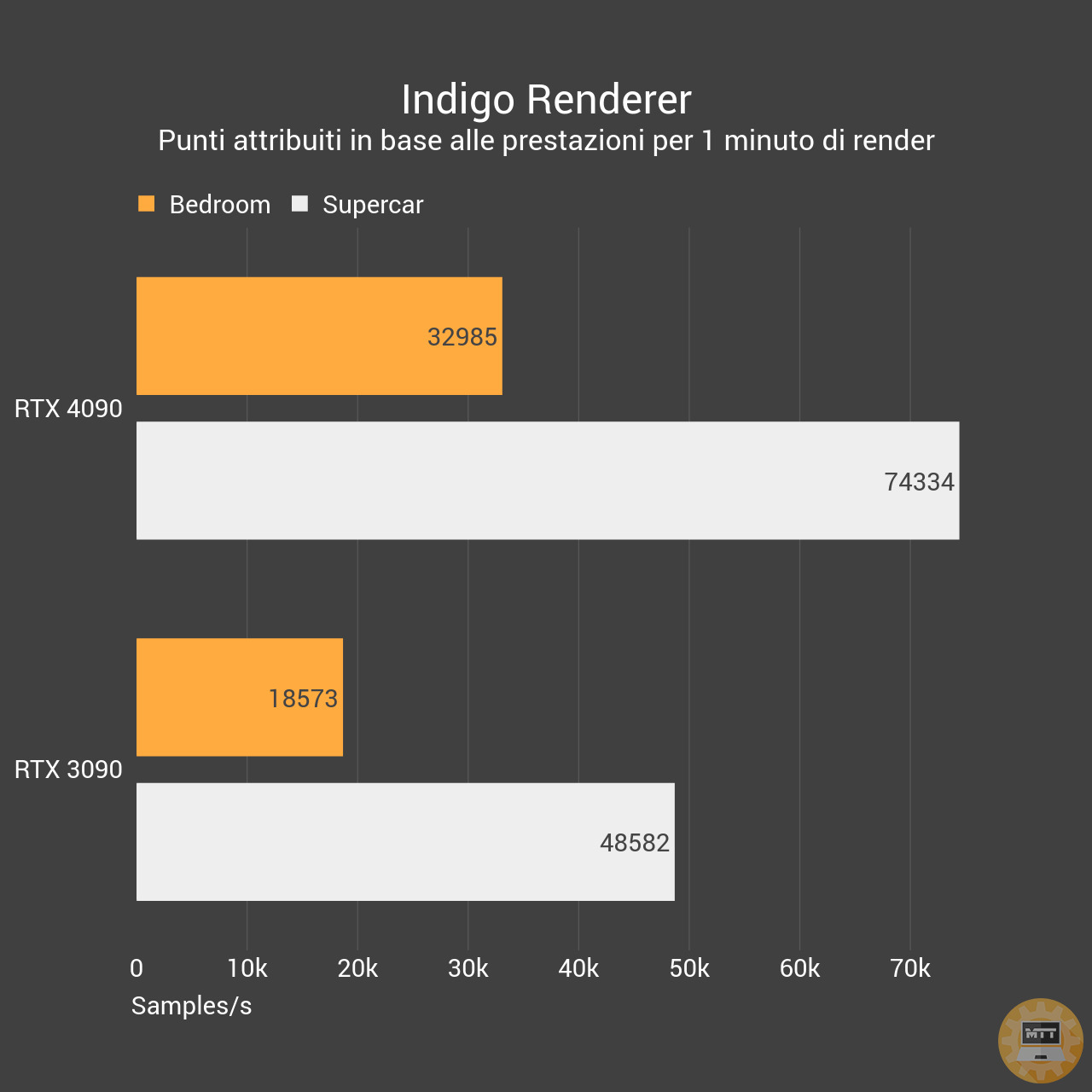

Per questo abbiamo approfondito l’argomento produttività partendo con dei benchmark in alcuni dei principali renderer GPU sul mercato, Vray e Indigo Benchmark. In entrambi la RTX 4090 supera la concorrente RTX 3090 con un ampio sorpasso.

A seguire il pacchetto Adobe, anche se abbiamo una vittima: After Effects. Purtroppo il programma ha avuto delle incompatibilità driver nel momento dei test e non abbiamo potuto analizzarlo correttamente. Ma Premiere e Photoshop ci mostrano un incremento prestazionale giusto, anche se non troppo significativo sul totale. Chiaramente un comportamento normale considerato che entrambi i programmi lavorano a stretto contatto con la CPU prima che con la scheda video e beneficiano maggioramente del contributo della prima, come After Effects, se non in fase di render o composizione.

Prestazioni - DLSS 3 #

L’aggiunta di Nvidia in questo ambito ci porta a delle prestazioni maggiori anche rispetto alla controparte DLSS 2 e si distaccanno decisamente da quanto offerto dall’FSR 2.0.

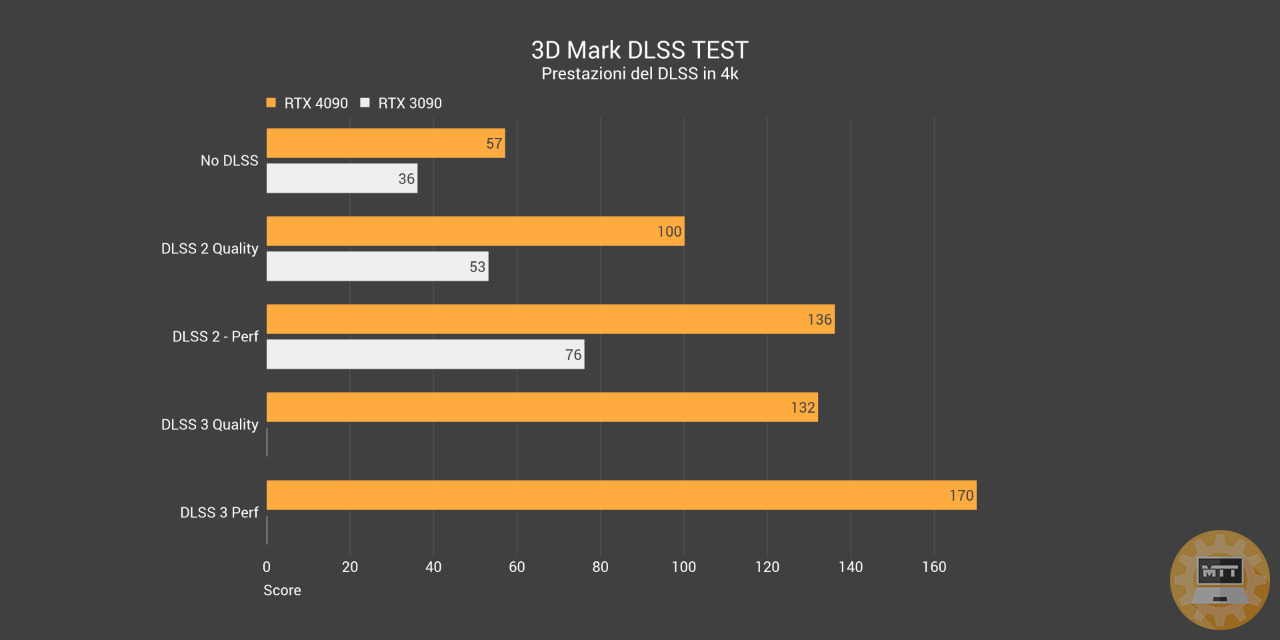

Come si può notare da questo primo test in 3D Mark, che ci ha concesso l’accesso in anteprima per il lancio, il DLSS 3 Quality supera il DLSS 2 Performance come numero di FPS, mantenendo però la maggior qualità apprezzabile nella prima impostazione.

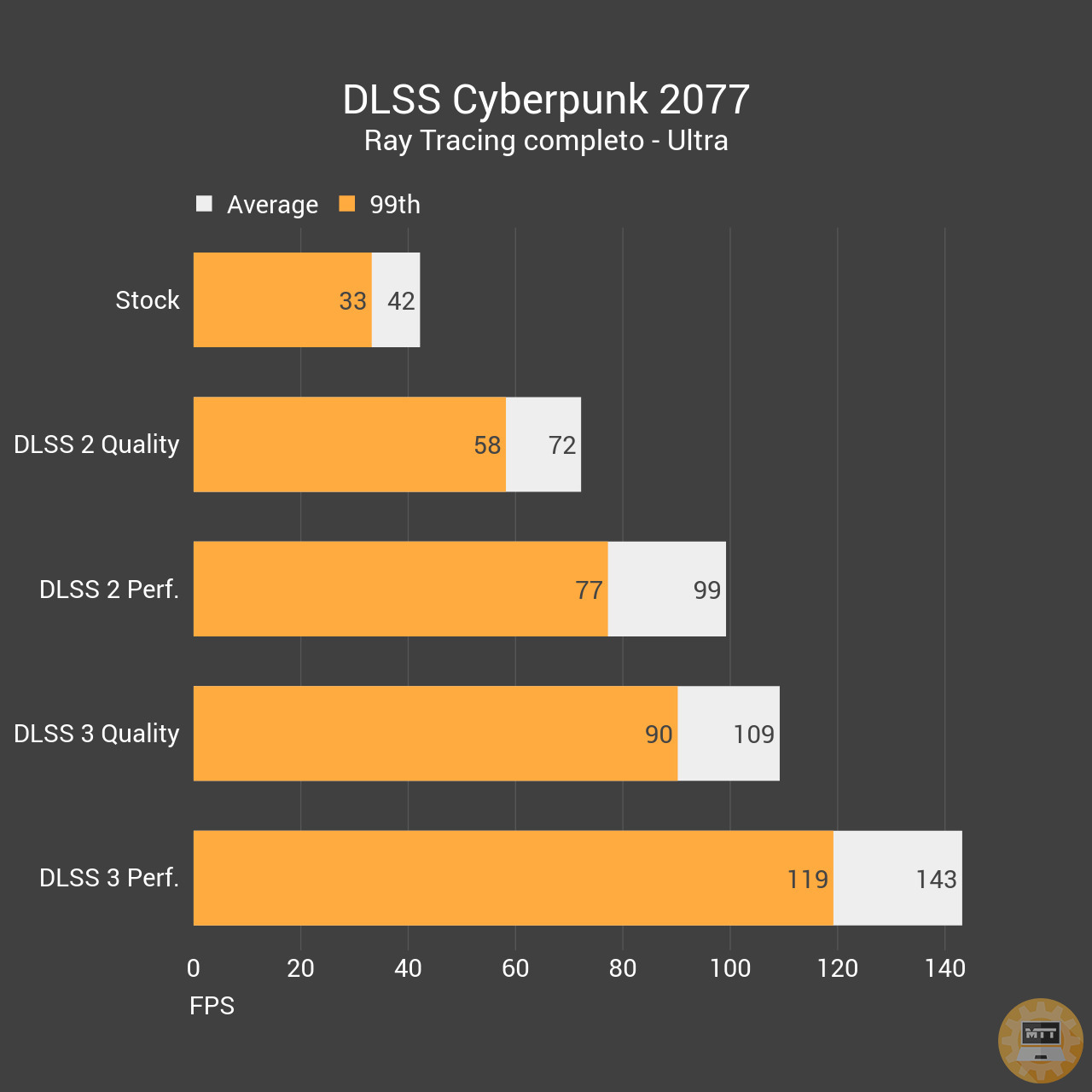

Questo si replica anche in Cyberpunk 2077, dove abbiamo riscontrato un incremento prestazionale notevole ma anche un (poco) sensibile incremento nella latenza. Niente di inficiante, ma ci sembra giusto riportarlo per completezza d’opera. Ad ogni modo il report quantitativo è che il DLSS 3 ha dei benefici numerici importanti sui nostri giochi preferiti, per quanto purtroppo limitato alle RTX 40.

🔗 RTX 4090 Gaming X Trio - Clicca qui per acquistare

Conclusioni #

Per concludere è giusto dare a Cesare quel che è di Cesare. La RTX 4090 è una scheda sensazionale dal punto di vista delle prestazioni e anche nel modello custom che abbiamo ricevuto si difende bene.

Tuttavia ottiene questi record a discapito di prezzi e consumi. I primi incrementano in maniera sensibile rispetto alla generazione precedente, portando la scheda Founders a 1979 euro ivati in Italia e 2169 euro per il modello custom. Per quanto riguarda i consumi, per quanto giustificati maggiormente dalla prestazioni , siamo comunque sui 400W. Un impatto notevole da considerare sulla bolletta per quanto non si giochi tutto il giorno.

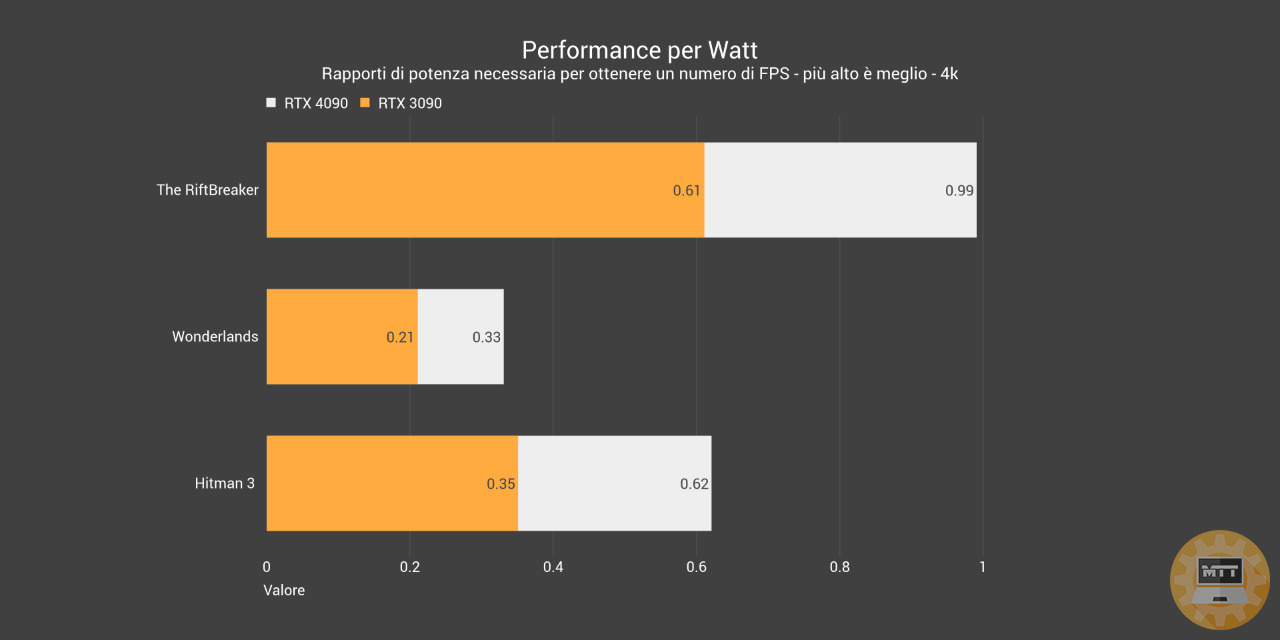

RTX 4090 vs RTX 3090: performance per watt

Quello che ci teniamo a far vedere è che comunque il rapporto performance/watt è molto migliorato rispetto alla RTX 3090 e RTX 3090TI (quasi uguali) e che quindi la direzione improntata da questa 4090 potrebbe essere ideale per quanto vedremo in futuro con i modelli 80, 70 e 60.

Insomma, una scheda che racconta una direzioni di mercato particolare, forse non per tutti. Decisamente un salto maggiore e interessante rispetto a quello visto tra Turing e Ampere, ma difficile da fare per il grande pubblico.