NVIDIA Chat with RTX: cos'è e come funziona

16 febbraio 2024

Al centro di questa innovazione si trova un chatbot basato su intelligenza artificiale, operante direttamente sulle GPU GeForce RTX 30 e 40. Questa tecnologia sfrutta TensorRT-LLM e il software Retrieval Augmented Generated (RAG), integrati senza soluzione di continuità nelle GPU RTX e ottimizzati grazie ai Tensor cores incorporati.

Il fine primario di Chat with RTX è rendere accessibile a tutti la potenza delle proprie schede grafiche per attività legate all’intelligenza artificiale. Fino ad ora, l’IA ha mostrato la sua efficacia prevalentemente nel campo visivo, con immagini e video, mentre le conversazioni online sono spesso state trascurate, limitate dai costosi requisiti dei modelli complessi ospitati nei grandi data center.

Per facilitare l’accesso a questa tecnologia anche per gli utenti comuni, NVIDIA ha sviluppato una soluzione che semplifica notevolmente il processo. L’applicazione opera direttamente sul dispositivo e può essere avviata dal browser, eliminando le complessità legate alla configurazione di nuove tecnologie.

Come installare Nvidia Chat with RTX #

Per provare il nuovo tool, basterà recarci a questo link ed avviare il download di una zip da 35GB. Durante l’installazione, vi saranno numerosi processi automatici ed essenziali che dilateranno di molto i tempi di installazione.

L’analisi dei file locali per ottenere contesto aggiuntivo richiederà tempo, variabile in base al numero di file presenti. Anche se attualmente in fase dimostrativa, Chat with RTX mostra promesse, nonostante i possessori di RTX della serie 20 possano trovarsi svantaggiati. La mancanza di supporto per le GPU con architettura Turing originale potrebbe estendersi alle schede della serie 20 in futuro, secondo le indicazioni di Nvidia, basate su vincoli temporali.

Come funziona #

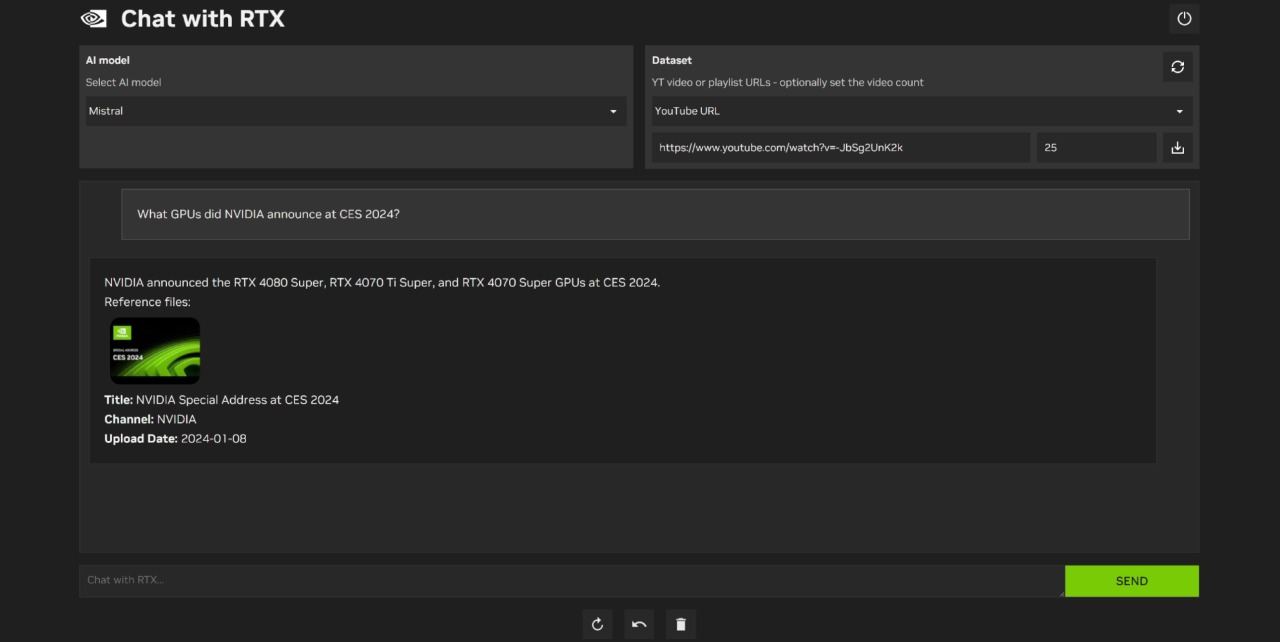

Chat with RTX si distingue non solo per l’elaborazione di testo, ma anche per la gestione di diversi formati di file, tra cui testo, pdf, doc/docx e xml. Sfrutta le capacità di Large Language Models rinomati come Mistral o Llama2 per generare risposte e può accedere a risorse online come video su YouTube.

Possiamo anche inserire URL specifici, come per video su YouTube o intere playlist, al fine di ottimizzare ulteriormente i risultati della ricerca nel dataset.

Crediti: Nvidia

Il nuovo applicativo ci consente di utilizzare modelli di linguaggio open source senza la necessità di connessione al cloud. Il vero svantaggio di “Chat with RTX” risiede fondamentalmente nei requisiti di sistema elevati e nelle dimensioni del download considerevoli, soprattutto se comparati alle soluzioni cloud. Per l’esecuzione, sarà necessaria una GPU RTX della serie 30 o successiva con almeno 8GB di VRAM e il sistema operativo Windows 10 o 11.

l’IA ci consente quindi di specificare i propri file in modo che possa produrre risposte adatte alle esigenze dell’utente. Possiamo importare vari formati di file, tra cui .txt, PDF, Word e documenti XML. I video di YouTube possono anche essere scaricati e analizzati dal chatbot.

Sostanzialmente, una volta terminata la fase di installazione ed importazione del dataset, funzionerà esattamente come ChatGPT ad esempio, però avrà una base di dati personalizzata e disponibile sempre in locale.

Fonte: VideoCardZ, TechPowerUp, WccfTech, Tom’sHardware, Nvidia