Nvidia ChatRTX: cos'è e come funziona

1 maggio 2024

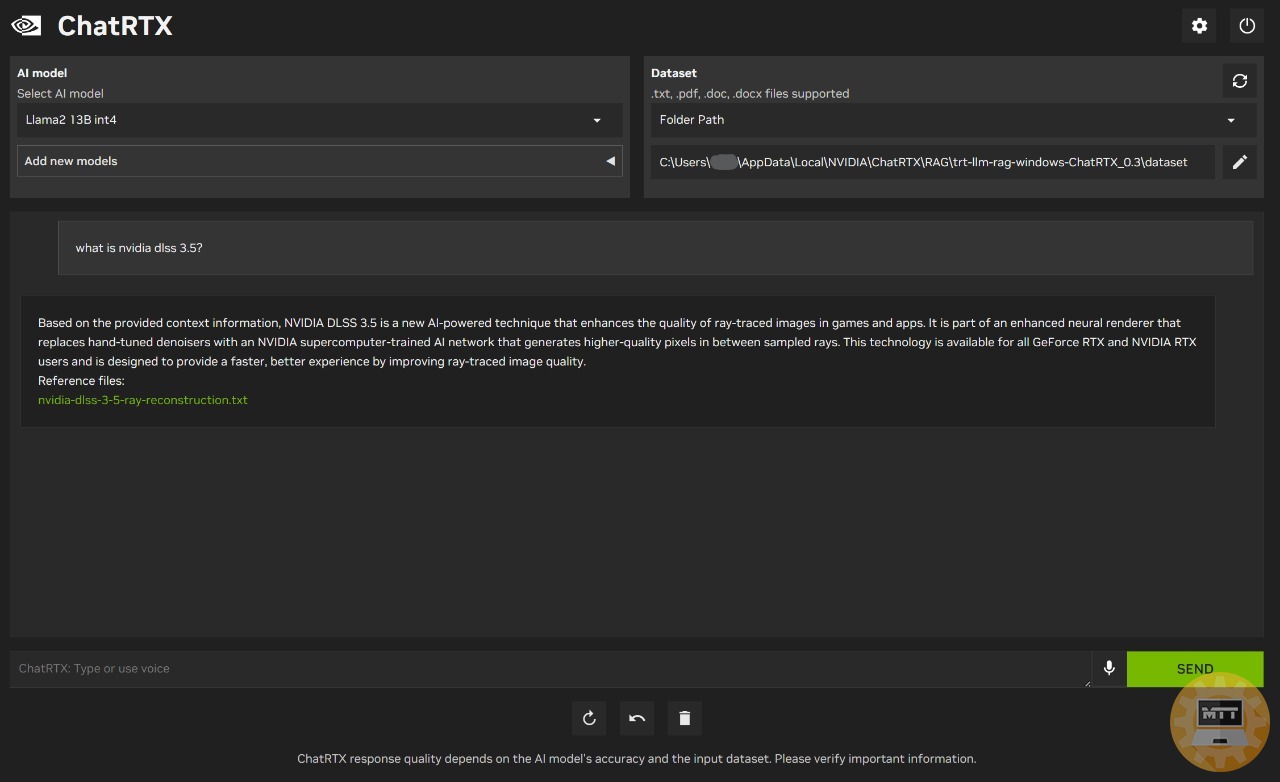

Come per la precedente versione, ChatRTX ci permette di eseguire completamente in locale un chatbot basato su IA capace di sfruttare i TensorRT-LLM e l'accelerazione RTX ed addestrare il modello in base a tutti i file supportati che andremo ad inserire nella cartella dedicata al dataset.

Il programma opera quindi direttamente sul nostro PC generando una interfaccia sul nostro browser. Al momento sono compatibili soltanto Google Chrome e Microsoft Edge; ma in futuro ne verranno implementati altri come Firefox.

Come installare Nvidia ChatRTX #

Alcuni accorgimenti #

- Assicuriamoci che la funzione di sospensione di Windows sia disattivata.

- Se l’installazione dovesse fallire per un qualche motivo, possiamo ripeterla selezionando l’opzione “esegui un’installazione pulita”.

- Se vogliamo utilizzare una directory diversa rispetto alla posizione predefinita, è importante verificare che non vi siano spazi nel percorso o nel nome della cartella.

- Se l’installazione continua a fallire nonostante numerosi tentativi, eliminiamo la seguente directory prima di procedere con un nuovo tentativo di installazione: C:\Users\“username”\AppData\Local\NVIDIA\RAG

Per provare il nuovo tool, basterà recarci a questo link ed avviare il download. Durante l’installazione, vi saranno numerosi processi automatici ed essenziali che dilateranno di molto i tempi di installazione.

L’analisi dei file locali per ottenere contesto aggiuntivo richiederà tempo, variabile in base diversi fattori come l’hardware della nostra build o la connessione ad internet.

Una volta terminato tutto il processo, ci verrà chiesto da Windows di concedere ulteriori permessi al programma. Accettiamo ed aspettiamo che si avvii automaticamente.

Se la procedura è proseguita senza intoppi, si aprirà in automatico un command prompt che ci mostrerà in tempo reale tutte le operazioni che il bot sta eseguendo per un corretto avvio e funzionamento. Questa funzione è molto utile anche in caso di debug ed analisi più approfondite del suo funzionamento.

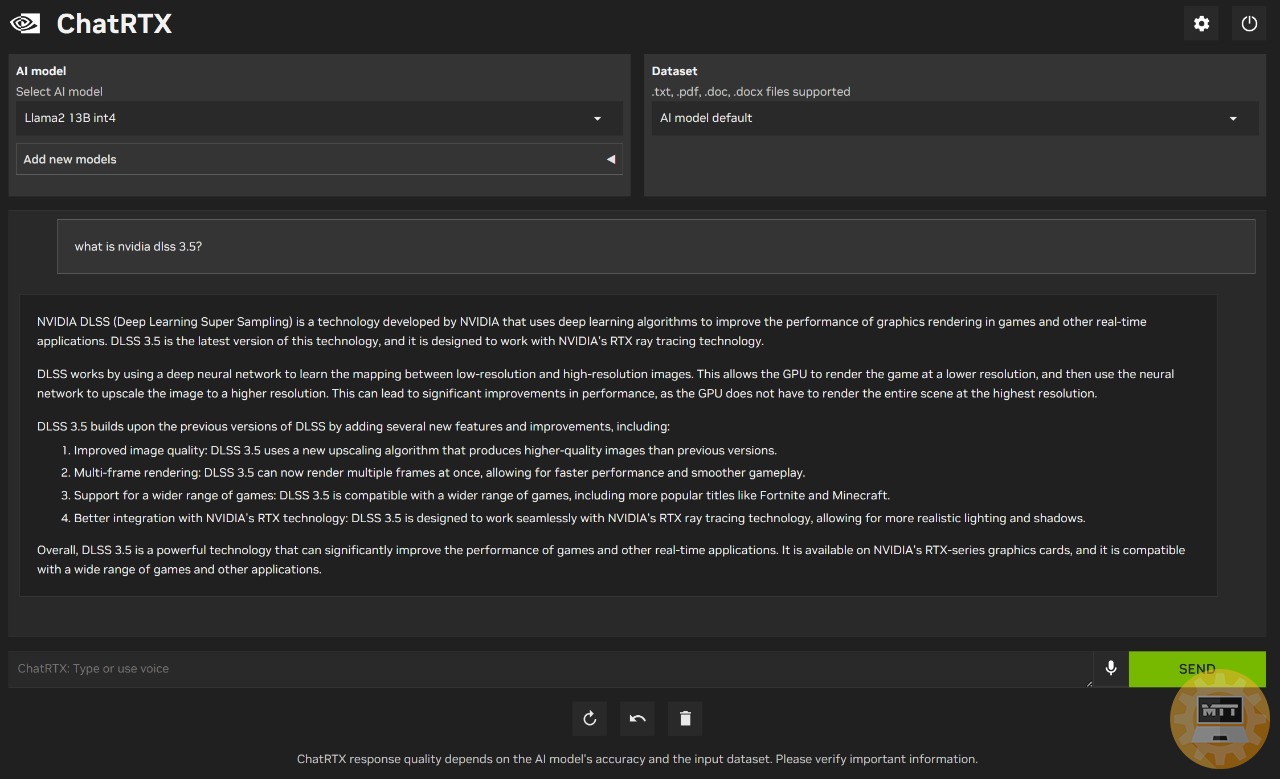

Come funziona #

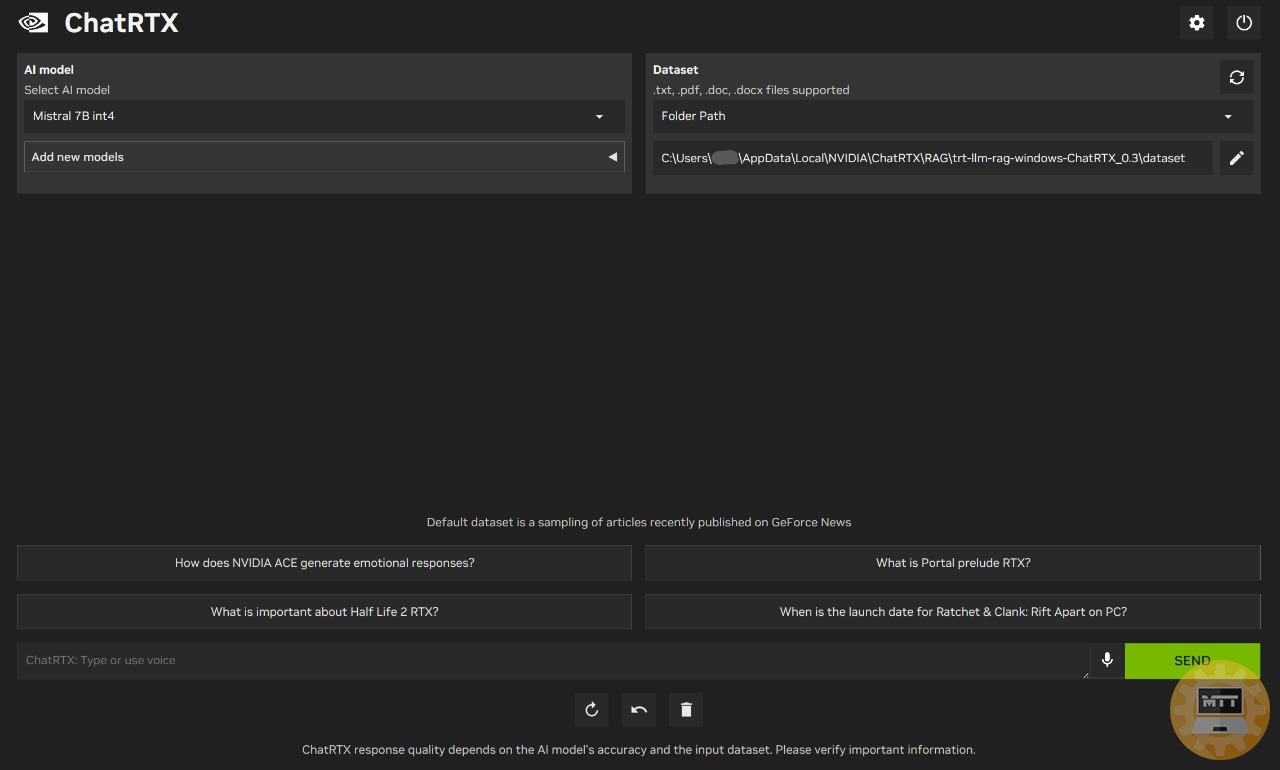

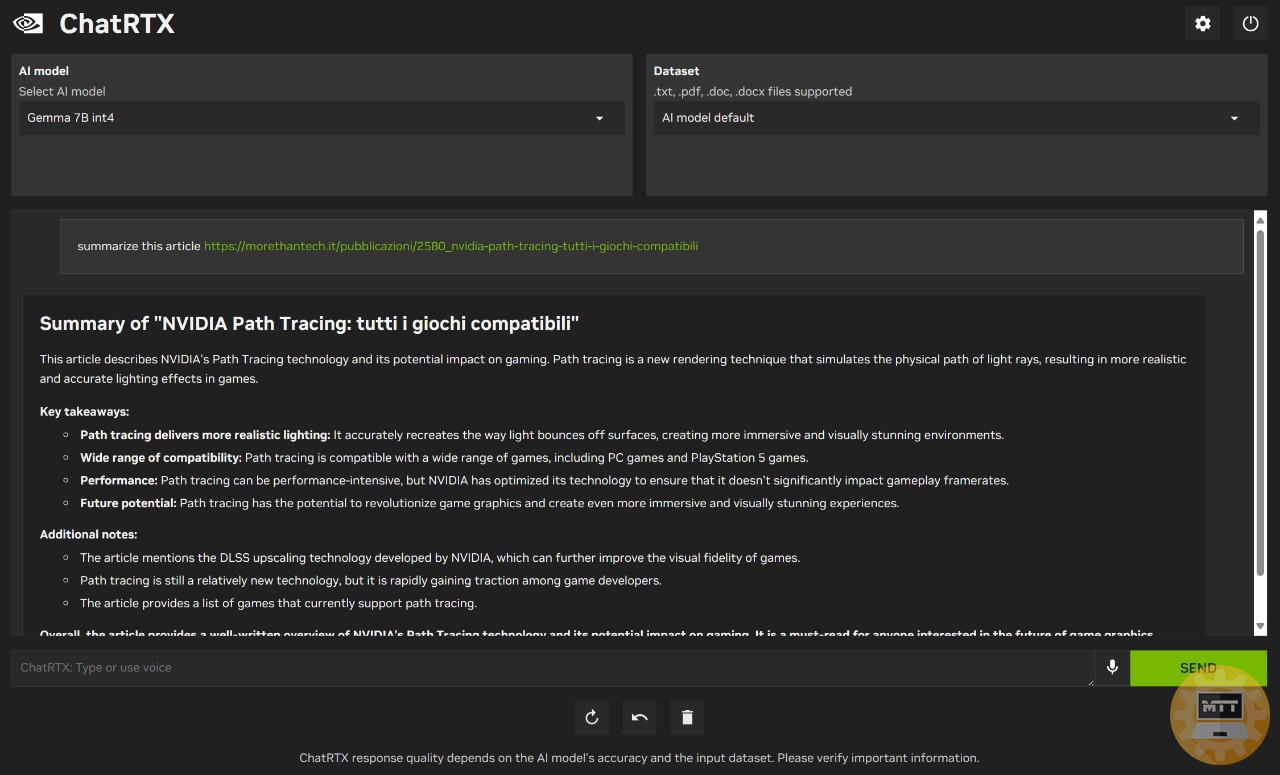

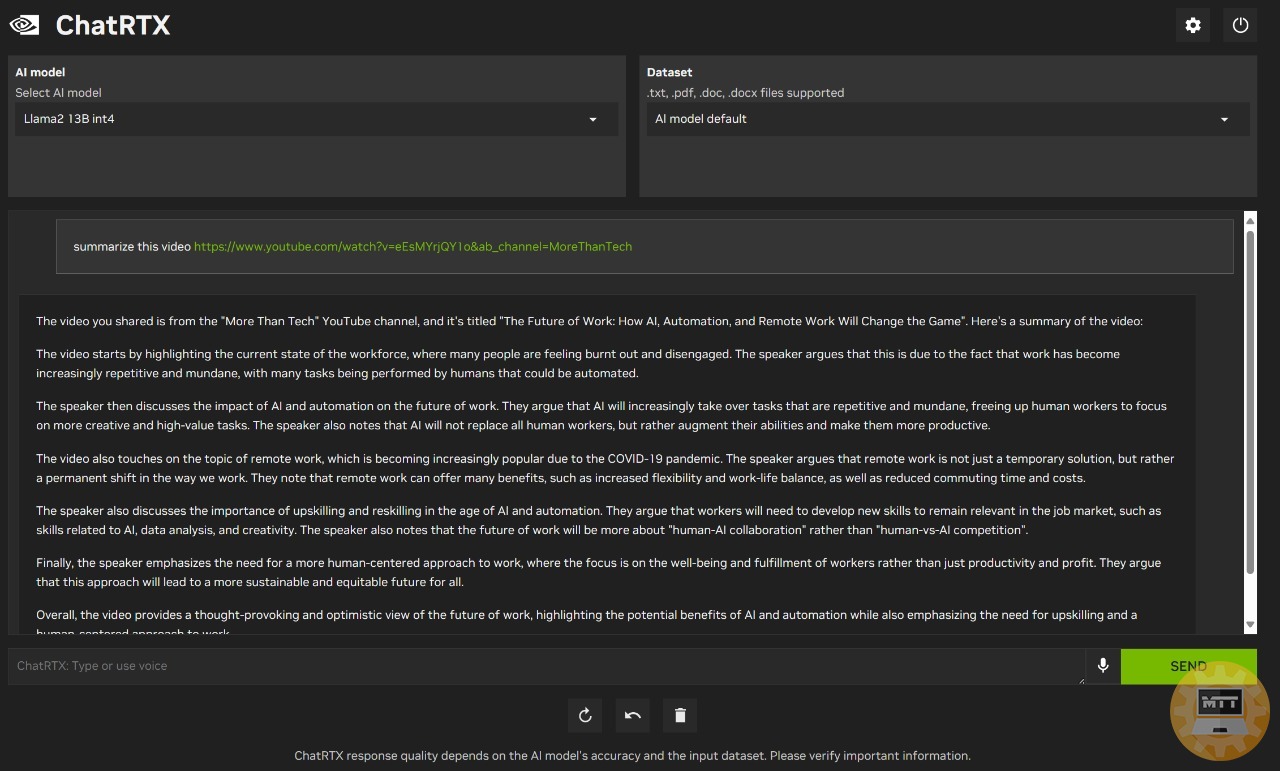

ChatRTX si distingue non solo per l’elaborazione di testo, ma anche per la gestione di diversi formati di file, tra cui testo, pdf, doc/docx e xml. Sfrutta le capacità di Large Language Models rinomati come Mistral o Llama2 per generare risposte pertinenti.

Il nuovo applicativo ci consente di utilizzare modelli di linguaggio open source senza la necessità di connessione al cloud. Il vero svantaggio di “ChatRTX” risiede fondamentalmente nei requisiti di sistema elevati e nelle dimensioni del download considerevoli, soprattutto se comparati alle soluzioni cloud. Per l’esecuzione, sarà necessaria una GPU RTX della serie 30 o successiva con almeno 8GB di VRAM e Windows 10 o 11.

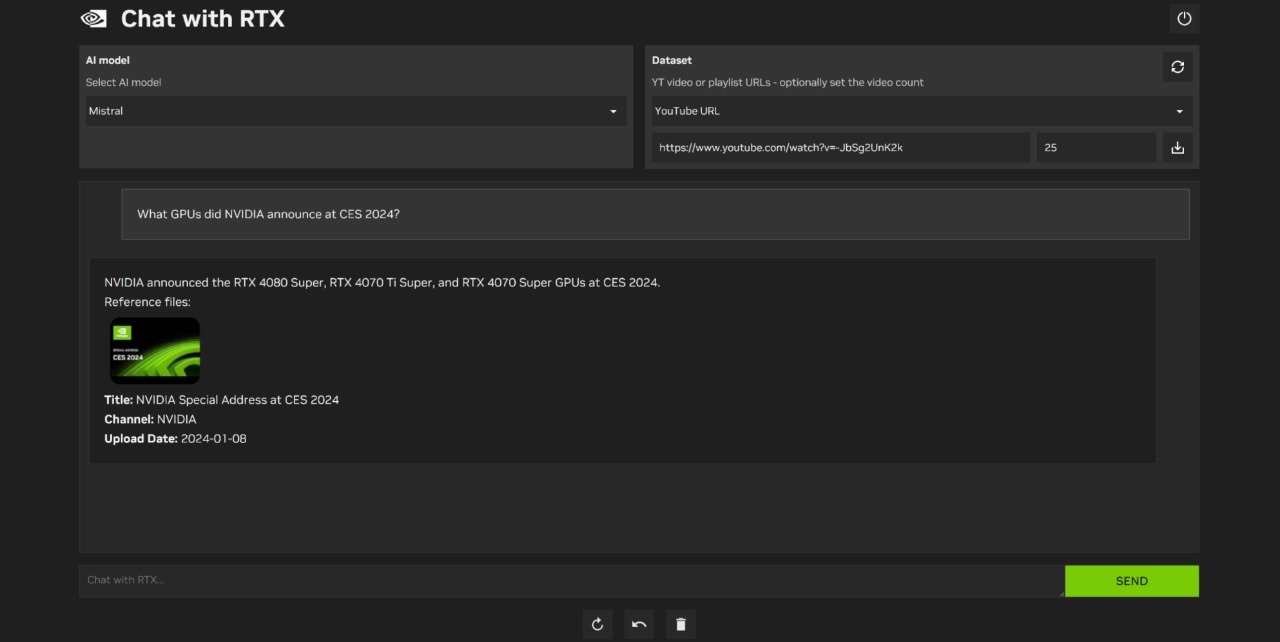

L’IA ci consente quindi di specificare i propri file in modo che possa produrre risposte adatte alle nostre esigenze. Possiamo importare vari formati di file, tra cui .txt, PDF, Word e documenti XML. I video di YouTube possono anche essere scaricati e analizzati dal chatbot.

Sostanzialmente, una volta terminata la fase di installazione ed importazione del dataset, funzionerà esattamente come ChatGPT ad esempio, però avrà una base di dati personalizzata e disponibile sempre in locale.

In alternativa possiamo utilizzare il dataset di default del modello di linguaggio che andremo ad installare tra quelli che Nvidia ha reso disponibili per il download.

Interfaccia #

Rispetto alla versione precedente, l’interfaccia ha subito alcuni cambiamenti importanti: non è più presente la funzione di scraping di link Youtube, però abbiamo un controllo migliorato sulla gestione del dataset e possiamo inoltre sfruttare la dettatura vocale, anche se soltanto in Inglese.

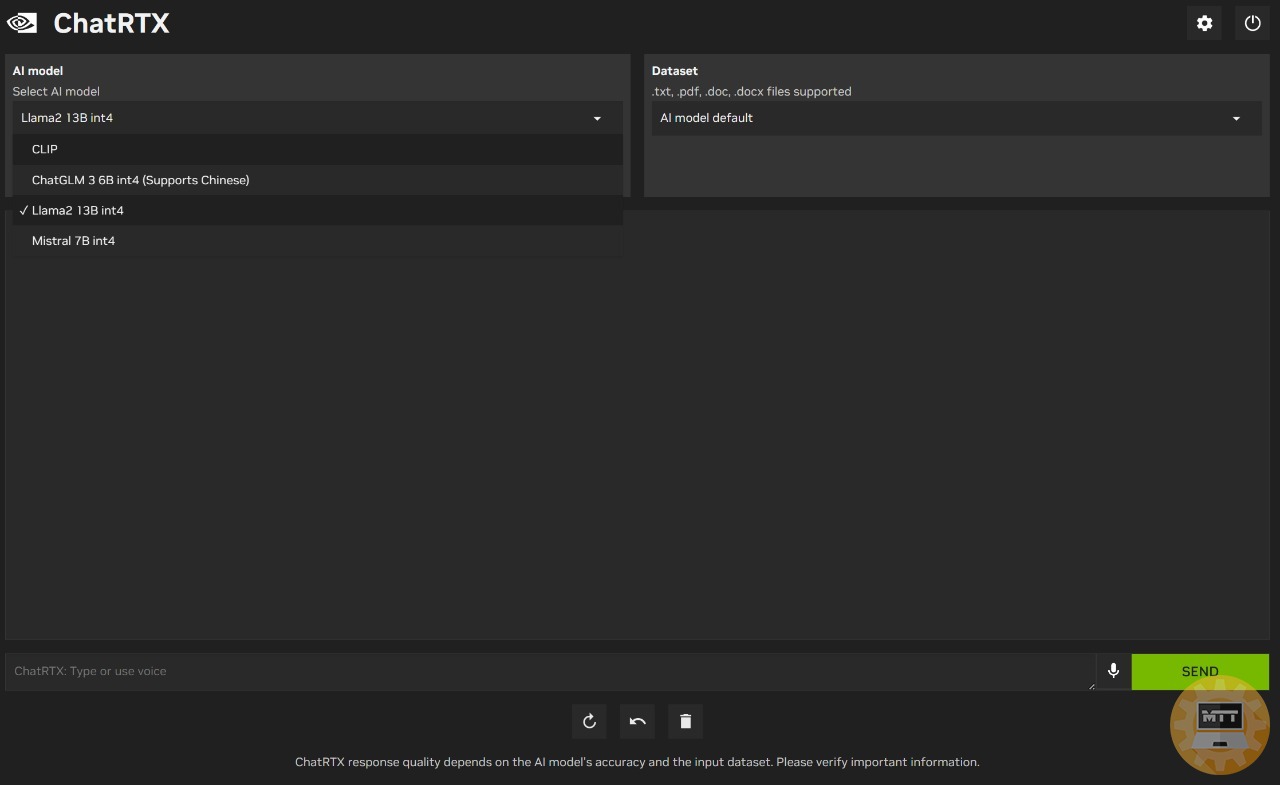

Modelli disponibili #

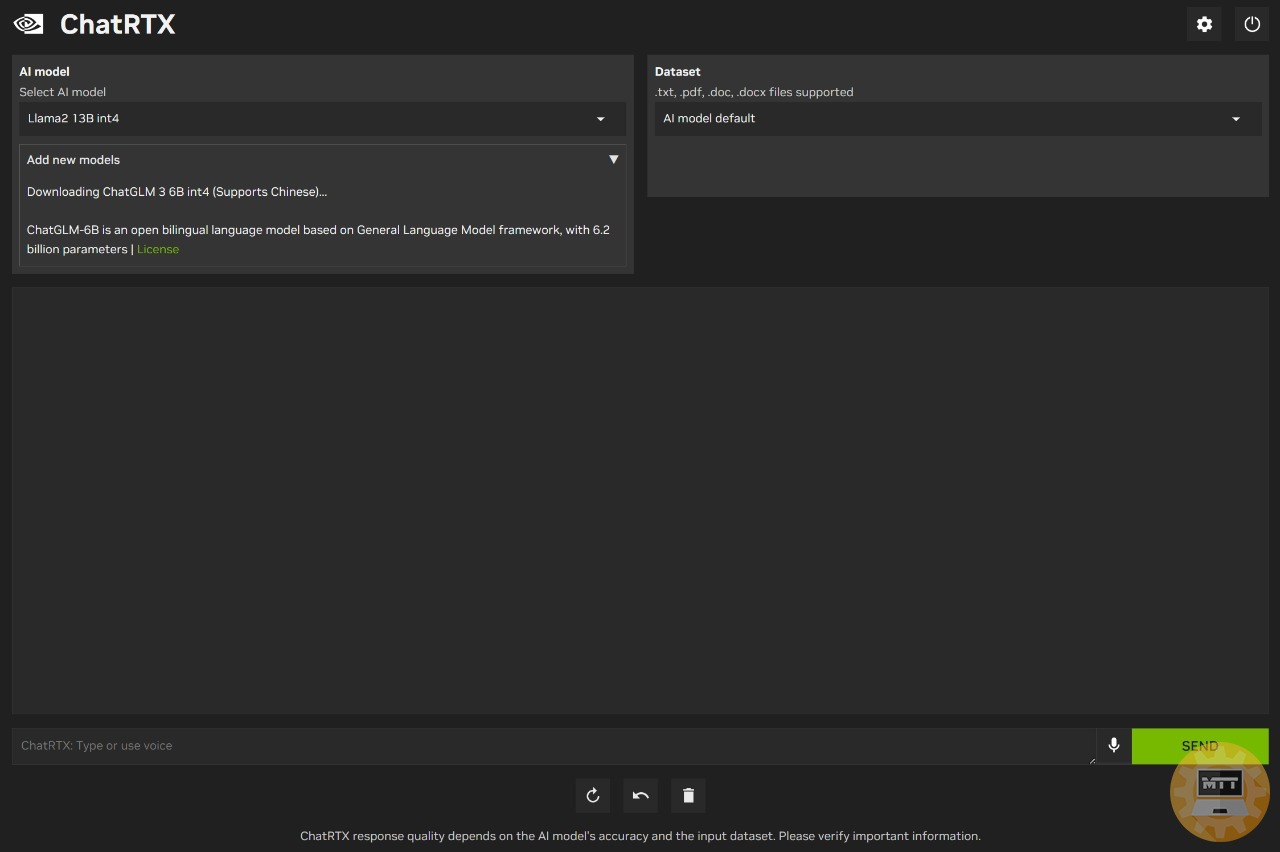

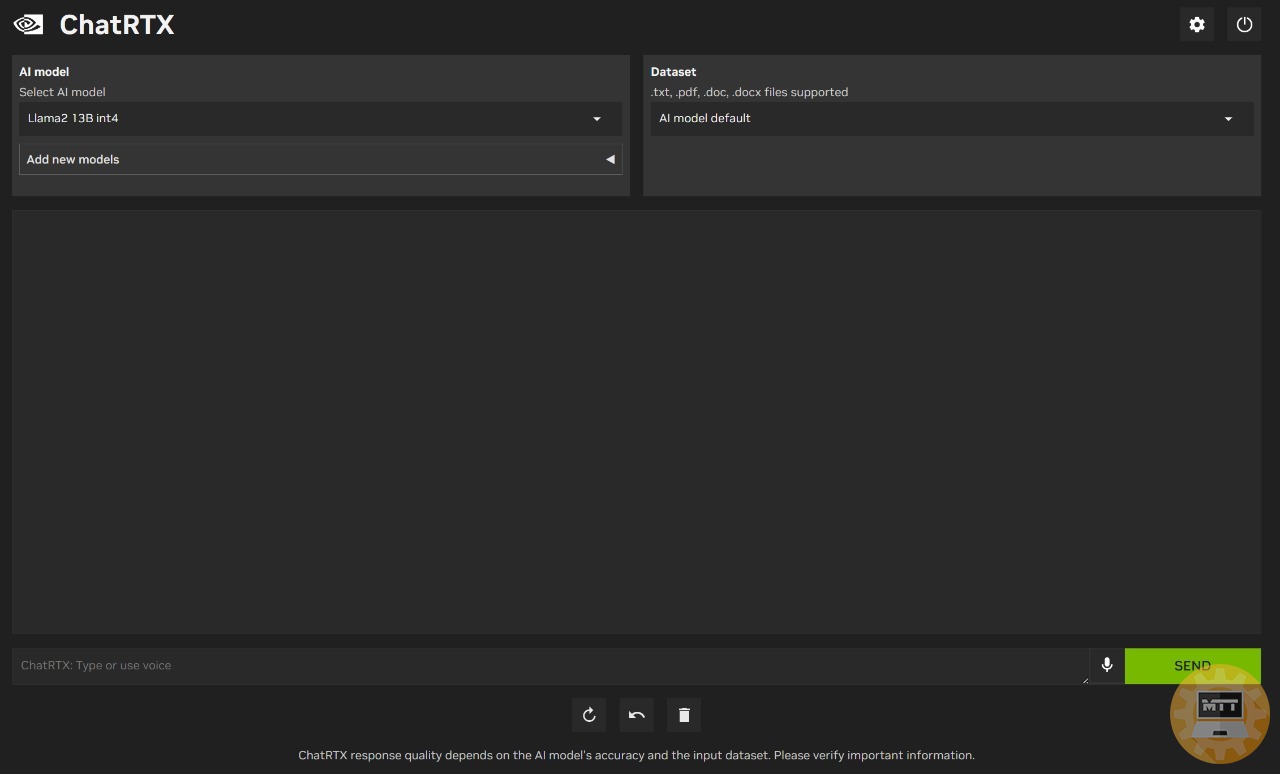

Possiamo sfruttare e testare in totale 5 language models differenti:

- Mistral 7B

- LLama2 13B

- ChatGLM 3 6B

- Gemma 7B

- CLIP

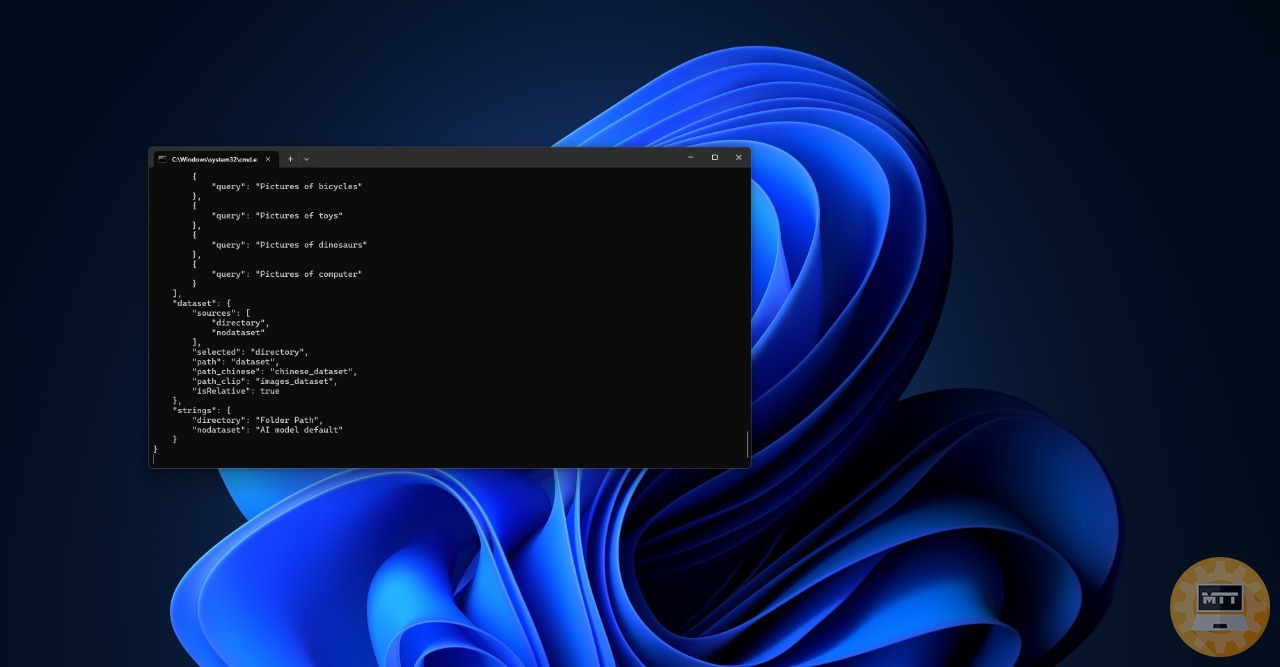

Senza scendere troppo nel dettaglio, sostanzialmente i primi 4 sono modelli capaci di elaborare e ragionare con file di testo, .pdf e .doc., mentre CLI ci permette di selezionare una o più immagini presenti nel nostro dataset in base al prompt fornito.

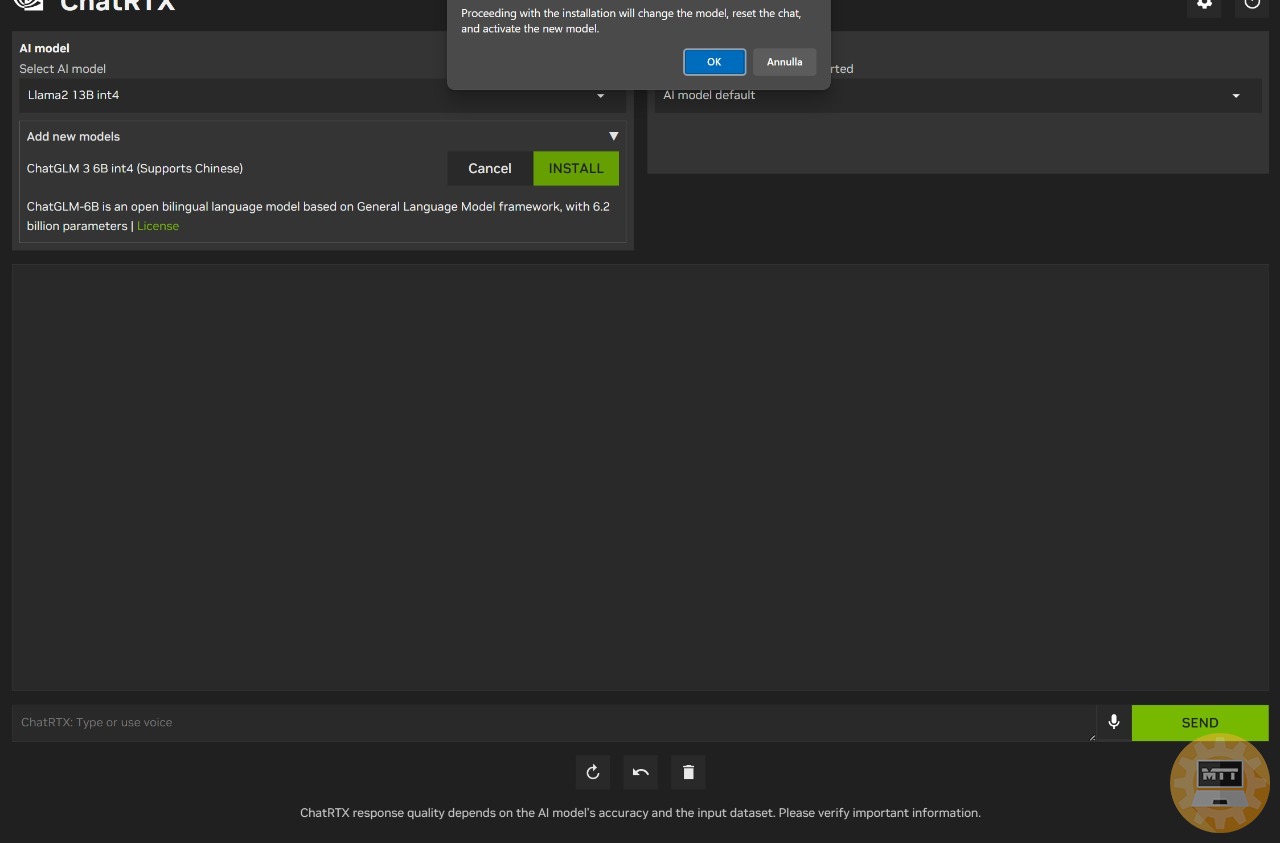

Il processo di installazione e gestione dei modelli è piuttosto semplice ed intuitivo; infatti con qualche click possiamo scegliere il modello da utilizzare.

Una volta selezionato il modello e terminato il download e la procedura di installazione automatica, non ci resterà altro che installarlo; procedimento che richiderà qualche minuto.

Possiamo scegliere quale LMM utilizzare in qualsiasi momento senza dover riavviare il chatbot.

Modelli IA #

LMM #

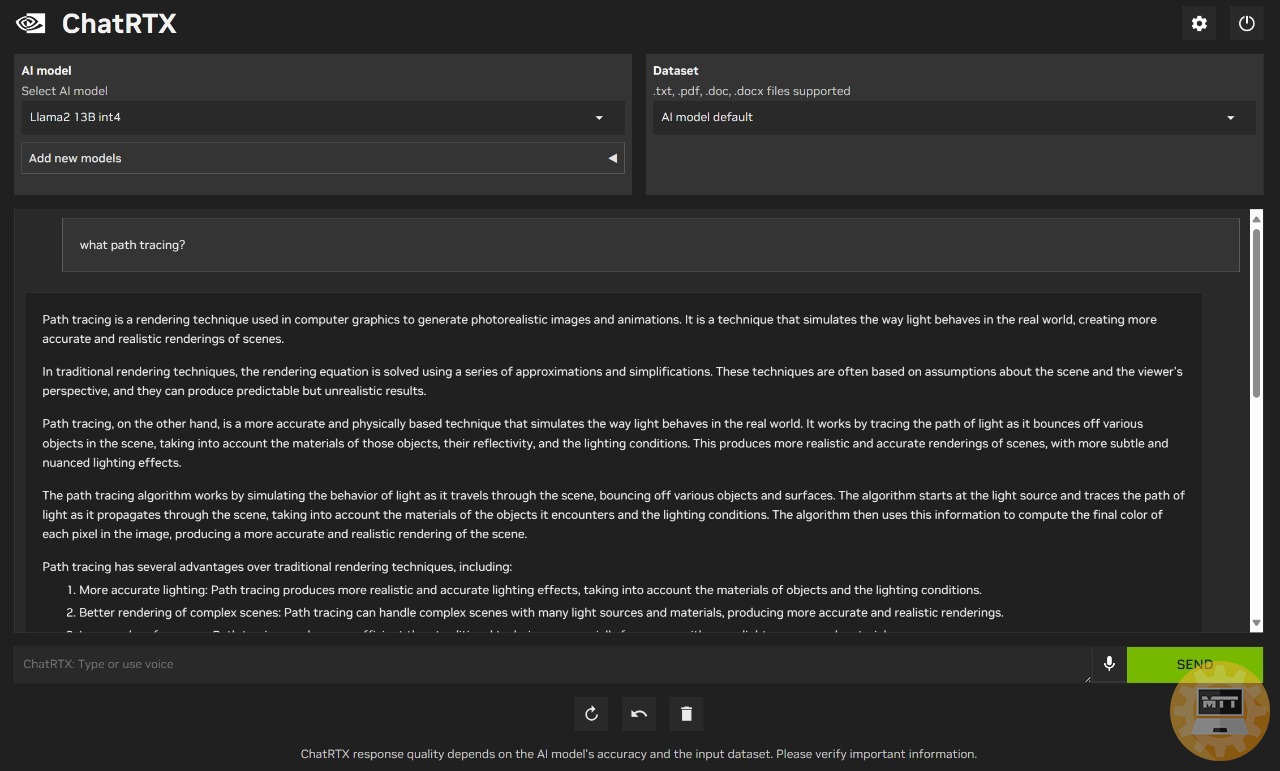

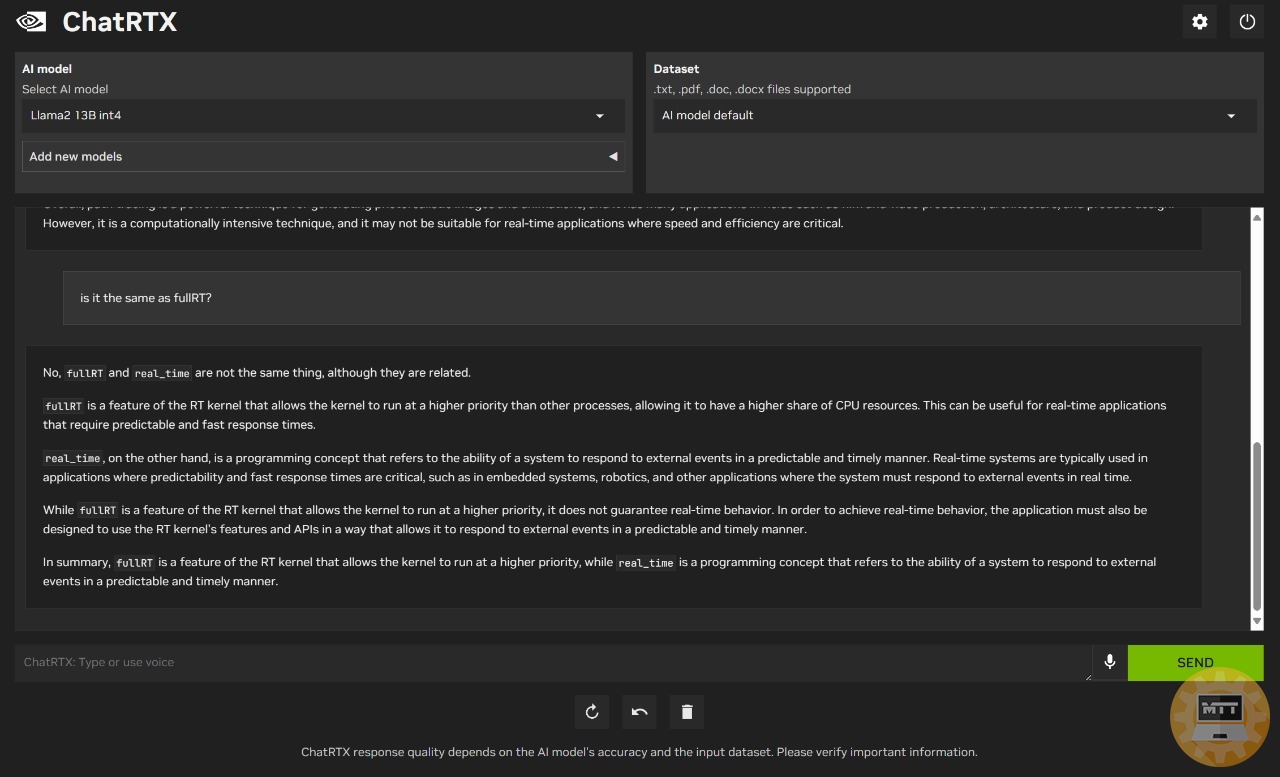

Come si comportano quindi questi modelli in casi d’uso più o meno complicati?

C’è da precisare che al momento l’app supporta soltanto la lingua inglese, anche se con qualche sforzo l’IA riesce a produrre dei testi in italiano più o meno leggibili. Non avendo un dataset ottimizzato per questa lingua è più che comprensibile.

Inolre non sono in grado di ricordare il contesto della conversazione; di conseguenza non potremo ricollegarci ad una domanda o risposta fornita in precedenza all’interno dello stesso storico chat.

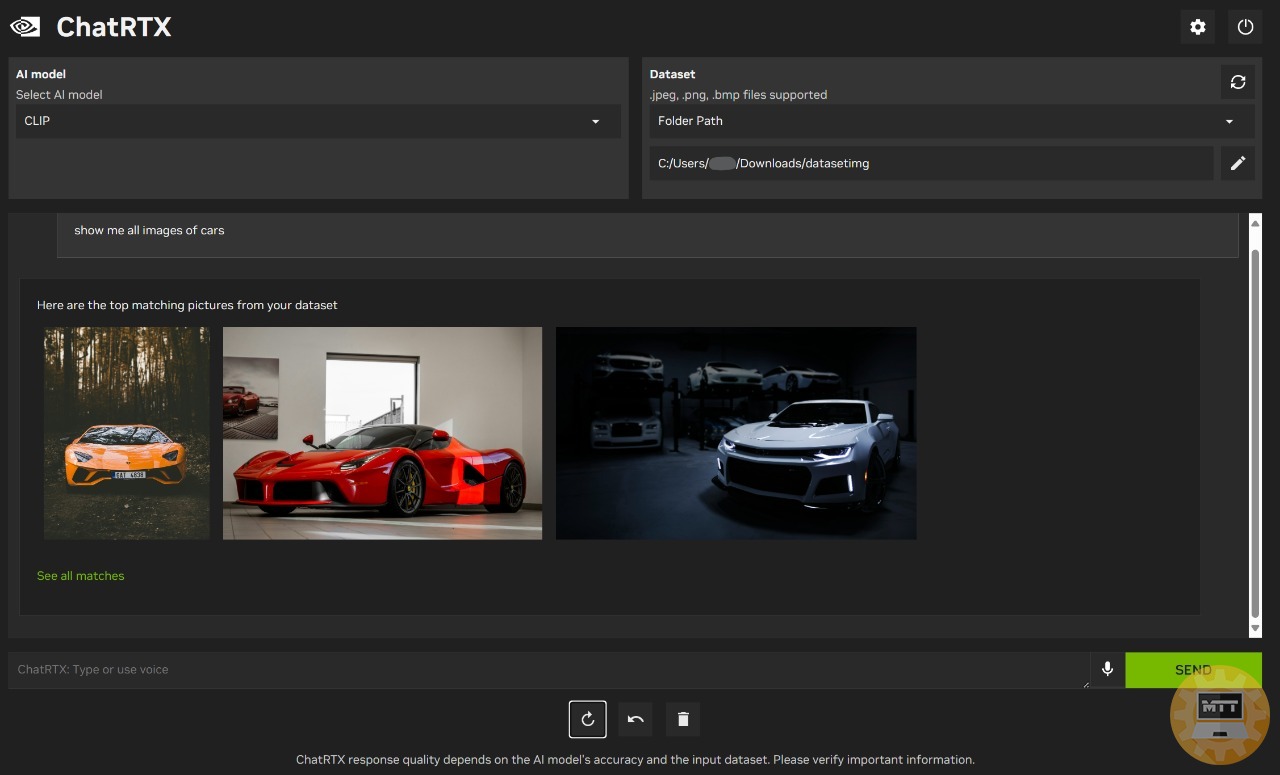

CLIP #

CLI è un modello IA particolare e capace di selezionare una o più immagini presenti nel nostro dataset in base al prompt fornito. Ovviamente l’affidabilità e la coerenza nelle risposte può variare in base a moltissimi fattori, come la definizione delle immagini, la chiarezza dell’oggetto presente in ognuna di esse, o più semplicemente la complessità del prompt inserito.

Ricordiamoci he questo programma non è nemmeno alla sua versione 1.0; di conseguenza ha ancora un margine di miglioramento molto interessante. Allo stato attuale risulta comunque un’opzione molto valida se siamo alla ricerca di un chatbot eseguibile in locale, offline e con dataset personalizzabile.