NPU vs GPU: cosa cambia?

26 giugno 2024

Le neural processing units (NPUs) rappresentano un componente specifico spesso paragonato alle graphics processing units (GPUs) per la loro abilità nell'accelerare i compiti di intelligenza artificiale.

Si tratta di dispositivi hardware progettati specificamente per eseguire attività di AI e machine learning con straordinaria rapidità.

Le NPU, sempre più diffuse, sono progettate per gestire in modo efficiente i compiti AI grazie a un’architettura ottimizzata e mirata. Al contrario, le GPUs, pur essendo potenti e versatili, si prestano a una vasta gamma di applicazioni, comprese quelle grafiche e computazionali.

Mentre le GPU offrono una notevole versatilità, le NPUs sono costruite con l’obiettivo principale di migliorare le prestazioni nelle operazioni di intelligenza artificiale, distinguendosi così per la loro specificità ed efficienza in questo ambito.

NPU: cos’è e come funziona #

Questo chip, noto anche come Neural Processing Unit, è un processore specializzato ideato per eseguire algoritmi di machine learning. A differenza delle CPU e delle GPU convenzionali, le NPU sono ottimizzate per eseguire calcoli matematici avanzati necessari per le reti neurali artificiali. Questi chip eccellono nel trattamento simultaneo di grandi volumi di dati, il che li rende particolarmente idonei per applicazioni come il riconoscimento delle immagini, l’elaborazione del linguaggio naturale e altre funzioni correlate all’intelligenza artificiale.

Per esempio, l’integrazione di un NPU con una GPU potrebbe consentire di gestire compiti specifici come il rilevamento degli oggetti o l’accelerazione delle elaborazioni grafiche.

Il machine learning rappresenta il cuore delle applicazioni di intelligenza artificiale, sebbene frequentemente venga confuso con l’IA stessa. Questo ambito costituisce una sotto-categoria dell’intelligenza artificiale, dove gli algoritmi apprendono dai dati a disposizione, producendo previsioni e decisioni senza richiedere istruzioni esplicite.

Esistono quattro principali tipologie di algoritmi di machine learning: supervisionato, semi-supervisionato, non supervisionato e di rinforzo.

Le NPU svolgono un ruolo fondamentale nell’efficiente esecuzione di tali algoritmi, gestendo operazioni come il training e l’inferenza. Queste fasi implicano l’elaborazione di vasti dataset per migliorare i modelli e fornire previsioni in tempo reale.

GPU: cos’è e come funziona #

Le GPU, o Graphic Processing Unit, sono nate inizialmente per ottimizzare l’elaborazione visiva nei videogiochi e nelle applicazioni multimediali.

Nel corso del tempo, hanno espanso il loro ambito d’azione, diventando cruciali per numerosi settori che richiedono elaborazioni parallele per gestire calcoli complessi.

La peculiarità distintiva delle GPU risiede nella loro capacità di eseguire rapidamente e efficientemente migliaia di operazioni simultanee di piccole dimensioni. Questa caratteristica le rende particolarmente adatte per compiti complessi come la generazione di immagini, la simulazione fisica e il training delle reti neurali.

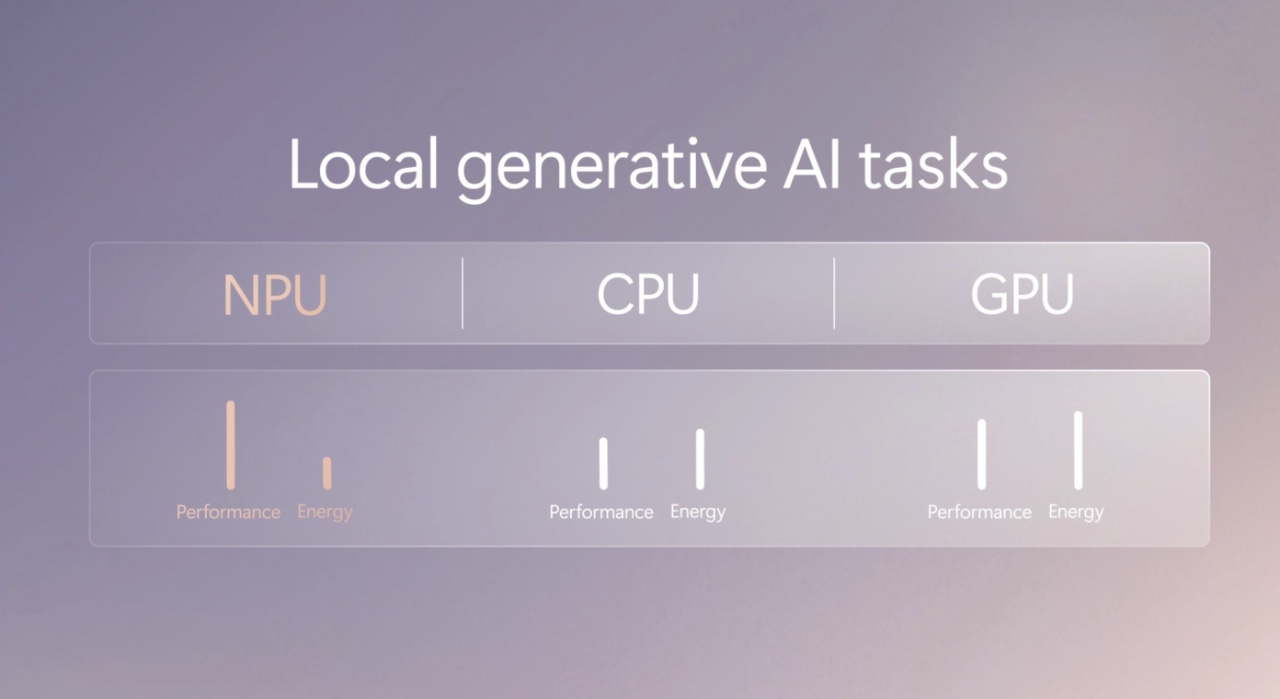

NPU vs GPU: Performance #

Le NPU si differenziano dalle GPU principalmente per la loro maggiore efficienza energetica e la capacità di prolungare la durata della batteria. Questi processori specializzati nelle reti neurali consumano significativamente meno energia rispetto alle GPU, pur mantenendo velocità operative paragonabili.

Questa distinzione sottolinea l’importanza delle moderne applicazioni delle reti neurali, piuttosto che delle differenze architetturali tra i due tipi di hardware.

Le NPUs sono ottimizzati appositamente per carichi di lavoro AI/ML e superano le GPU nelle attività più complesse come l’inferenza e il training del deep learning.

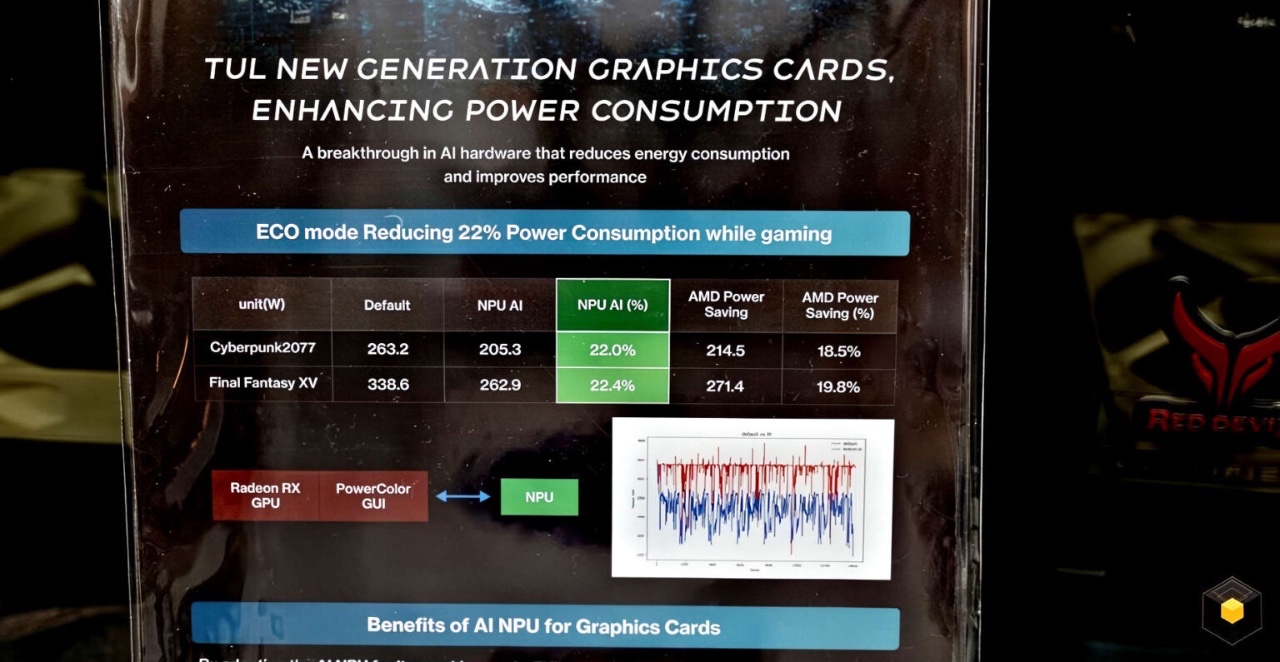

PowerColor sta per lanciare delle nuove schede video Radeon custom con NPU integrata

Le differenze principali #

Le NPU sono progettate con un’architettura focalizzata sul processing parallelo, a differenza delle GPU che impiegano un maggior numero di core versatili.

Le NPUs utilizzano numerosi processori più piccoli e integrano gerarchie di memoria specializzate, ottimizzazioni del flusso dati e capacità di gestire efficacemente complessi carichi di lavoro di deep learning.

D’altra parte, le GPU, pur disponendo di un numero elevato di core versatili adatti a una vasta gamma di compiti paralleli, non sono progettate specificamente per algoritmi di reti neurali come le NPUs.

Grazie alla loro progettazione mirata, le NPU si distinguono per l’efficacia nel migliorare le operazioni necessarie per i modelli di deep learning. Questa specializzazione permette loro di superare nettamente le CPU e, in determinati contesti, anche le GPU, nei carichi di lavoro legati all’intelligenza artificiale.

Le NPUs eccellono soprattutto nelle attività intensive di deep learning come il NLP, il riconoscimento vocale e la visione artificiale, a differenza delle GPU che, sebbene più orientate all’uso generale, possono incontrare difficoltà nel competere con le NPUs nel processamento di modelli linguistici su vasta scala o nelle applicazioni di edge computing.

Fonte: DigitalTrends, TechSpot, WindowsCentral, Microsoft